توضیحات

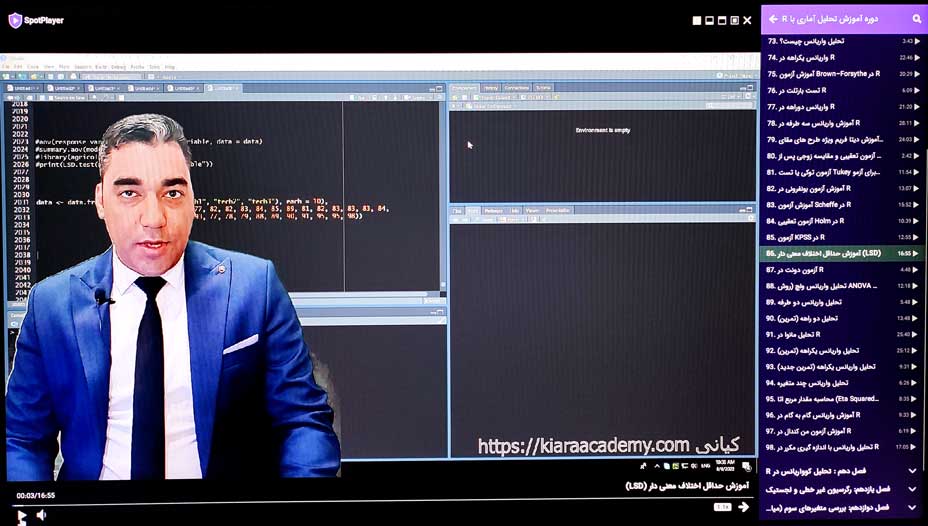

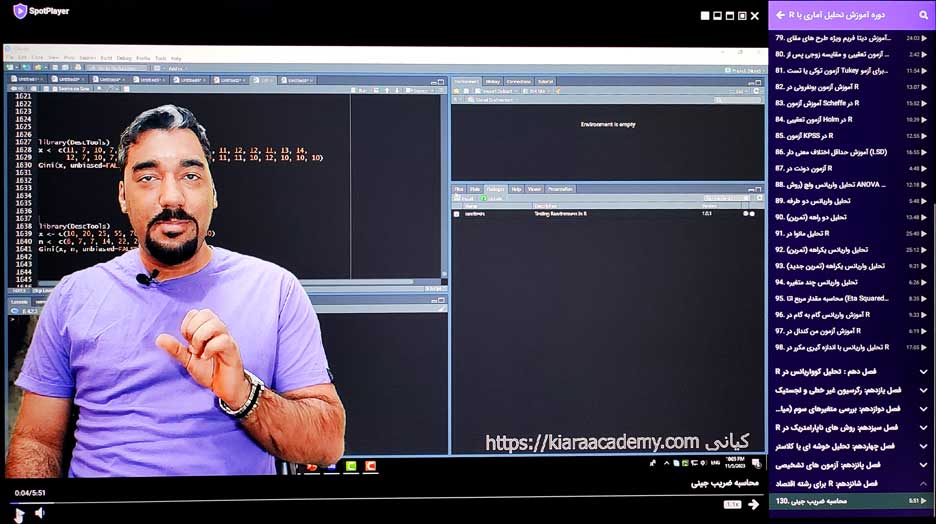

در دوره آموزش تحلیل آماری با R همراه من باشید تا به صورت کامل تحلیل داده ها را با R بیاموزید. من در دوره آموزش تحلیل آماری با R سعی کرده ام جامع ترین آموزش تحلیل آماری با R در ایران را آموزش بدهم. بیایید ابتدا نگاهی به نحوه ارایه دوره و بخش هایی از تدریس دوره R بیاندازیم:

| تعداد فصل های دوره | 19 فصل |

| تعداد جلسات دوره | 218 جلسه |

| تایم کامل دوره | 44 ساعت و 56 دقیقه |

| نرم افزار های استفاده شده در دوره | نرم افزار R- نرم افزار SPSS ورژن 27 – Excel – نرم افزار جامووی – نرم افزار JASP- نرم افزار Random Number Generator- نرم افزار MonteCarlo PA |

| تعداد کتاب ها و جزوات | 19 جزوه در قالب فایل PDF |

| محتوای تدریس شده | 1. مباحث نظری آمار و روش های آماری 2.اجرای روش های آماری 3.آموزش تفسیر و تحلیل داده ها 4. آموزش گزارش نویسی تحلیل ها 5.آموزش پایان نامه نویسی و رساله دکتری |

| آیا در دوره R دیتا تحلیل آماری نیز ارایه می شود؟ | بله برای همه فصل ها دیتا مخصوص ارایه می شود |

| حجم کامل دوره | 36 گیگابایت |

| آیا دوره آپدیت می شود؟ | بله هر ماه دوره آپدیت می شود و جلسات جدیدی به دوره اضافه می شود |

| دوره چگونه به ما ارایه می شود؟ | دوره در قالب لایسنس است که پس از نصب نرم افزار می توانید از همه جلسات دوره با دسترسی به اینترنت استفاده کنید |

| آیا از خارج از ایران هم می توان در دوره ها شرکت کرد؟ | بله در هر کشوری باشید می توانید با اتصال به اینترنت به دوره دسترسی داشته باشید |

1. فصل اول: شروع کار با R:

| عنوان جلسه | تایم جلسه |

| مقدمه تحلیل آماری | 20:26 |

| مقدمه ای بر نرم افزار R | 4:33 |

| جلسه نصب R | 8:56 |

| متغیر چیست؟ فرق بین متغیر مستقل و وابسته چیست؟ | 10:41 |

| جلسه وارد کردن داده ها در اکسل | 32:30 |

| جلسه وارد کردن داده ها در R | 25:33 |

| شخصی سازی نرم افزار R | 14:41 |

| آموزش دیتا فریم در R | 16:25 |

| آزمون فرضیه در R | 41:32 |

| جلسه تعریف متغیرها و توابع آماری ریاضیاتی در R | 21:16 |

| داده گمشده یا ناموجود (Missing Data) در R | 34:53 |

| آموزش ایجاد لیست در R | 3:06 |

| راهنمای استفاده از دیتا داخلی R | 5:21 |

| محاسبه درصد بر اساس گروه در R | 3:45 |

| تبدیل درصد به اعشار در R | 4:12 |

| توابع در R | 9:55 |

| غیر فعال کردن نماد علمی در R | 3:02 |

| اسم گذاری روی متغیر کیفی | 4:18 |

2. فصل دوم: تصحیح دیتا و آمار توصیفی

| عنوان جلسه | تایم جلسه |

| آمار توصیفی چیست؟ | 3:37 |

| جلسه شروع آمار توصیفی | 12:58 |

| پاک سازی داده ها | 9:00 |

| حذف دیتا مسئله دار | 7:50 |

| نحوه محاسبه انحراف استاندارد در R | 25:04 |

| آموزش محاسبه ضریب تغییرات در R | 10:08 |

| آموزش تست Jarque-Bera در R | 6:15 |

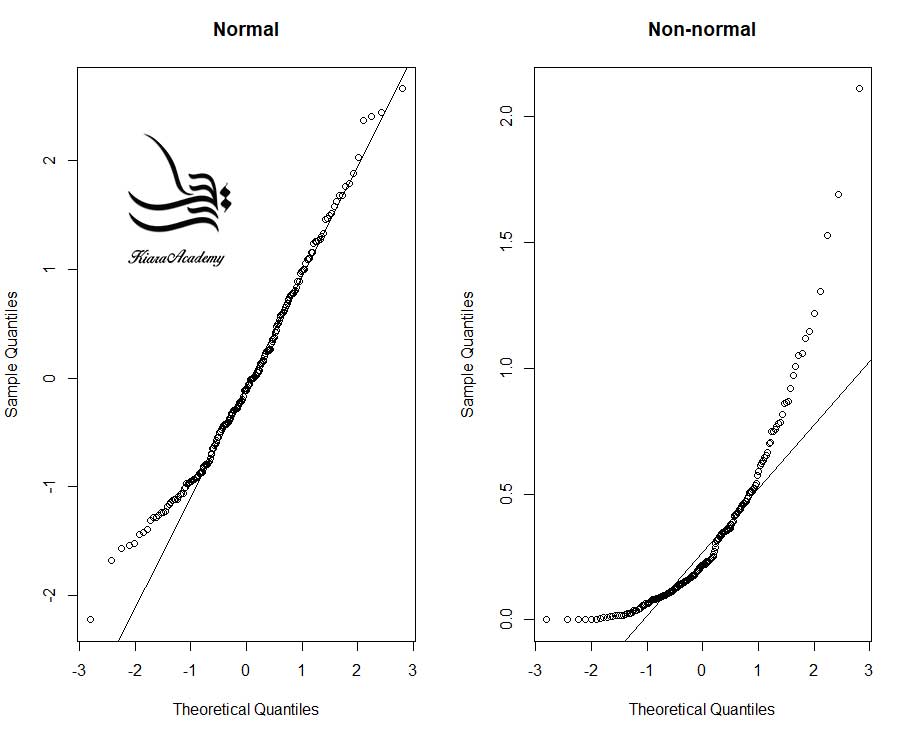

| آموزش ترسیم و تفسیر نمودار Q-Q در R | 11:50 |

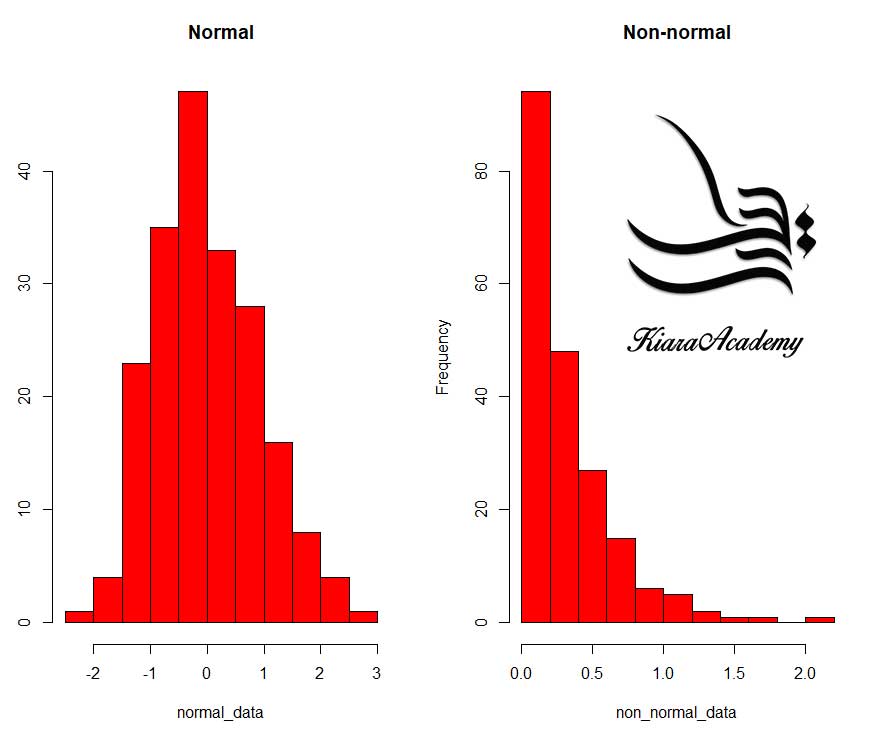

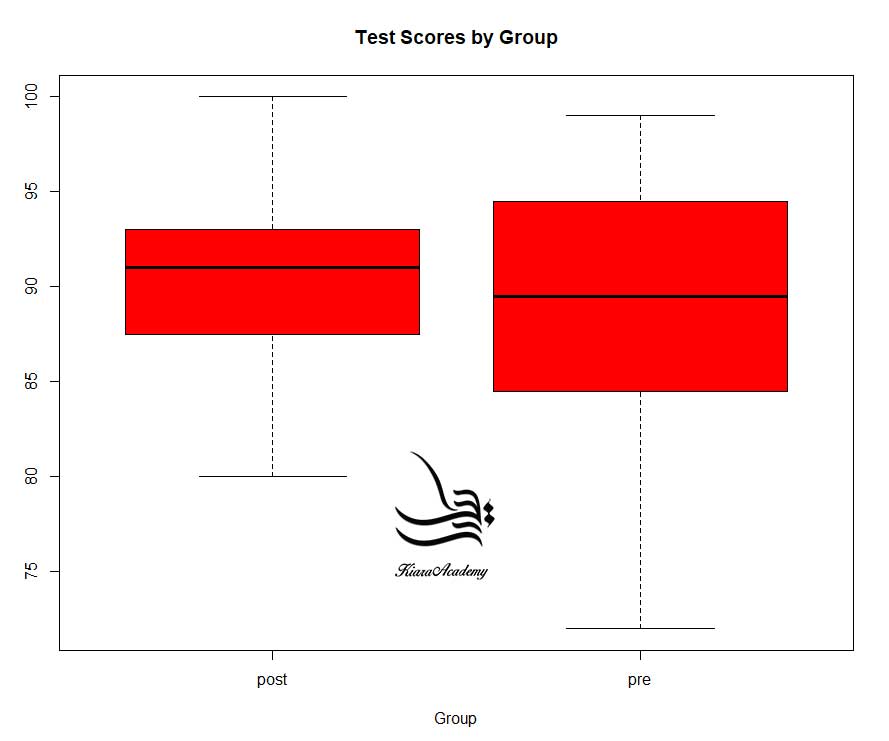

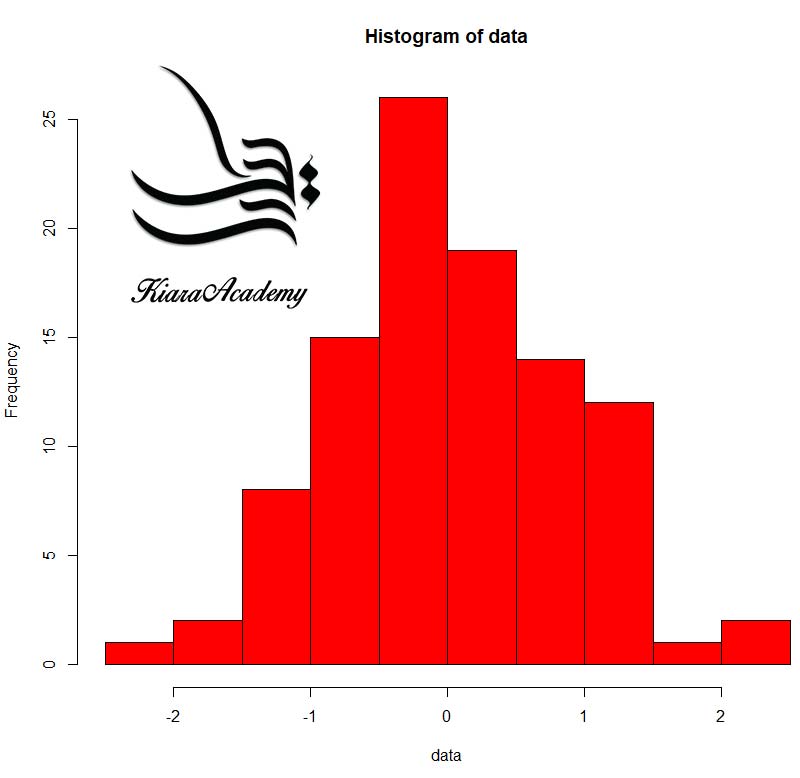

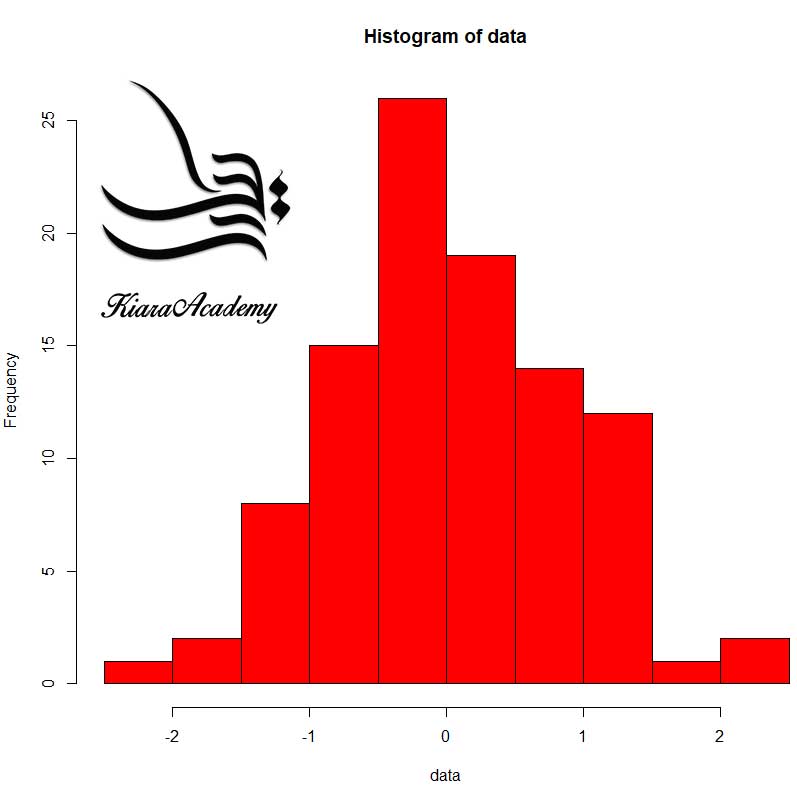

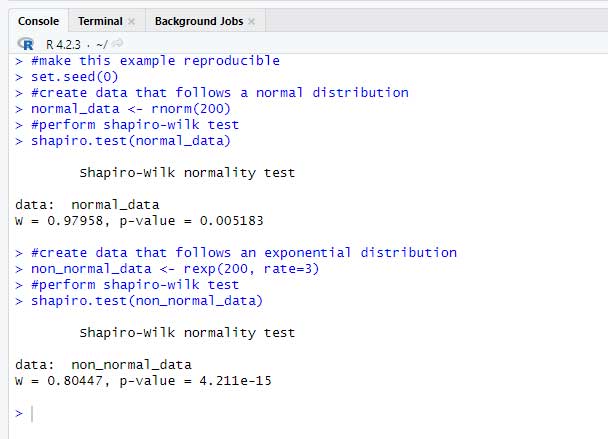

| آزمون شاپیرو ویلک (Shapiro-Wilk Test) | 15:28 |

| آزمون کولموگروف اسمیرنف (Kolmogorov-Smirnov) | 12:43 |

| اجرای آمار توصیفی در R | 40:51 |

| گزارش نویسی آمار توصیفی با جامووی | 18:31 |

| خلاصه سازی دیتا | 20:32 |

| آزمون تصادفی بودن (RUN) در R | 5:08 |

| لیبل گذاری روی نمودار | 9:02 |

| نحوه ایجاد متغیر طبقه ای و توصیف آن در R | 8:42 |

| آموزش ایجاد نمودار نواری در R | 6:31 |

| ایجاد نمودار Ogive در R | 6:04 |

| نحوه محاسبه نسبت در R | 5:20 |

| محاسبه انحراف مطلق میانه در R | 9:25 |

3. فصل سوم: دستکاری داده ها

| عنوان جلسه | تایم جلسه |

| دستگاری داده ها چیست؟ | 3:33 |

| دستور recode یا کدگذاری مجدد: جلسه 1 | 23:18 |

| دستور recode یا کدگذاری مجدد: جلسه 2 | 11:46 |

| دستور recode یا کدگذاری مجدد: جلسه 3 | 11:35 |

| آموزش دستور Compute در R | 18:12 |

| نمونه گیری از دیتا | 9:02 |

| اسم گذاری روی درامد | 6:21 |

| خلاصه فصل دستکاری دیتا در R | 16:04 |

4. فصل چهارم: آزمون های همبستگی

| عنوان جلسه | تایم جلسه |

| روش همبستگی در آمار چیست؟ | 5:17 |

| روش همبستگی پیرسون (Pearson Correlation) | 26:19 |

| روش همبستگی اسپیرمن (Spearman Correlation) | 15:48 |

| ضریب همبستگی tau-b (τb) کندال | 6:51 |

| همبستگی پیرسون و کندال و اسپیرمن در R | 11:59 |

| تست دقیق فیشر : جلسه اول | 8:39 |

| تست دقیق فیشر : جلسه دوم | 10:47 |

| کرولیشن بر اساس گروه در R | 3:38 |

| آزمون کرامر Cramer’s V | 27:15 |

| ضریب همبستگی جزئی (Partial Correlation) در R | 10:43 |

| روش همبستگی با کتابخانه JMV | 17:41 |

| محاسبه همبستگی دو رشته ای نقطه ای در R | 5:49 |

| محاسبه همبستگی Polychoric | 4:00 |

| محاسبه ضریب فی در R | 6:59 |

| جمع بندی و گزارش نویسی تحقیقات همبستگی | 19:06 |

5. فصل پنجم: آزمون های تی

| عنوان جلسه | تایم جلسه |

| آزمون تی در آمار | 5:07 |

| آزمون تی مستقل | 15:05 |

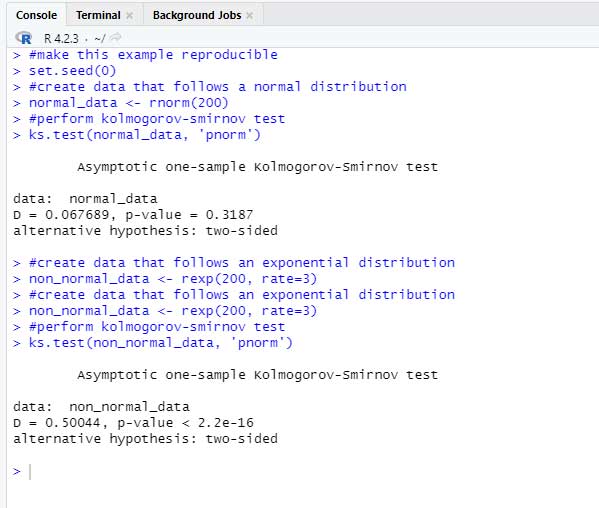

| آزمون تی وابسته | 18:01 |

| آزمون تی تک نمونه ای | 11:57 |

| اندازه اثر | 5:18 |

| آموزش تست F در R | 11:08 |

| تست لون برای برابری واریانس ها در R | 13:30 |

| آموزش آزمون Z در R | 33:18 |

| تست نسبت واریانس در R | 12:47 |

| تی تست با استفاده از کتابخانه JMV | 26:46 |

| جمع بندی و گزارش نویسی تحقیقات مقایسه ای با تی تست | 13:18 |

6. فصل ششم : بررسی پایایی در R

| عنوان جلسه | تایم جلسه |

| پایایی چیست؟ | 7:37 |

| سنجش پایایی با آلفای کرونباخ در R | 27:23 |

| روش کودر ریچاردسون (KR 20) | 23:09 |

| بررسی پایایی با کتابخانه JMV | 17:22 |

| پایایی با روش بازآزمایی | 3:39 |

| پایایی با روش فرم های موازی | 4:30 |

| جمع بندی و گزارش نویسی پایایی | 22:45 |

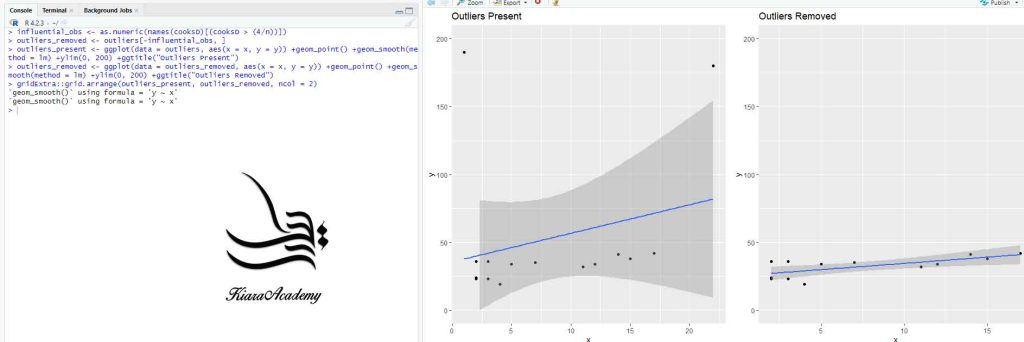

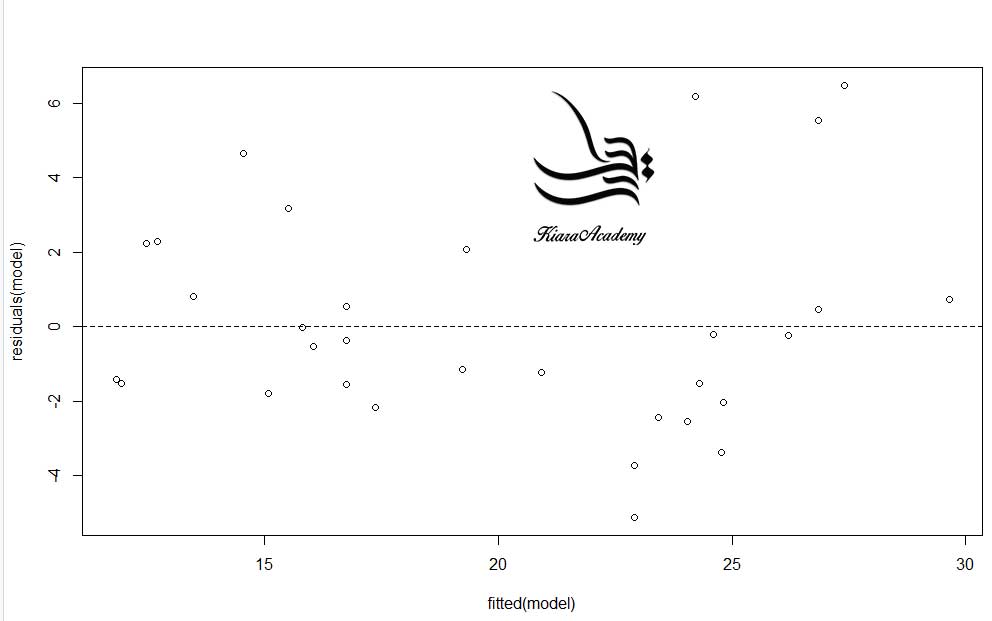

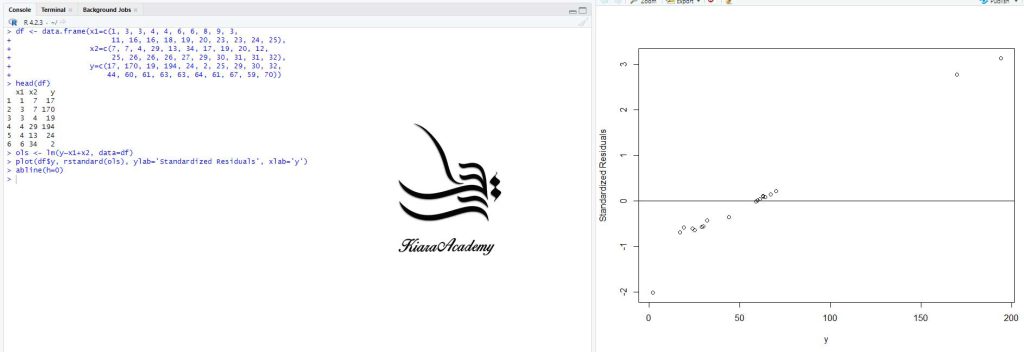

7فصل هفتم: تحلیل رگرسیون در R

| عنوان جلسه | تایم جلسه |

| تحلیل رگرسیون چیست؟ | 5:27 |

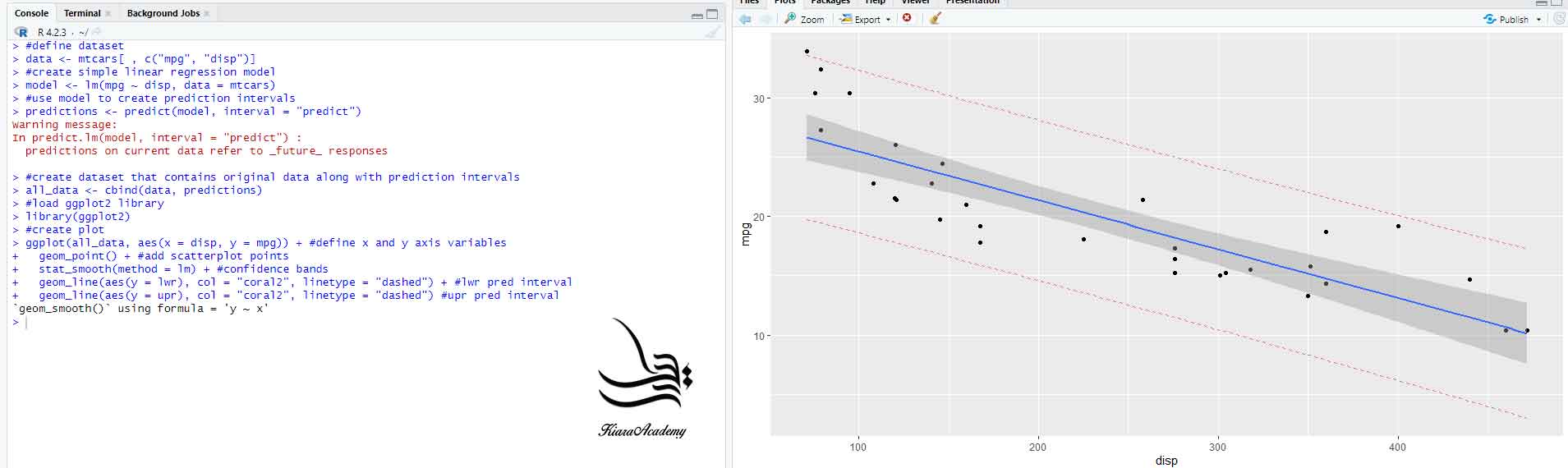

| آموزش رگرسیون خطی ساده | 10:54 |

| بررسی مدل رگرسیون و فاصله رگرسیونی | 20:54 |

| آموزش رگرسیون خطی چندگانه | 20:55 |

| محاسبه ضریب تورم واریانس (VIF) در R | 17:55 |

| آموزش آزمون اندرسون-دارلینگ در R | 18:10 |

| تحلیل رگرسیون با استفاده از کتابخانه JMV | 20:01 |

| آموزش آزمون والد (Wald Test) | 8:28 |

| تفسیر خروجی مدل رگرسیون در R | 14:48 |

| رگرسیون خطی (تمرین) | 15:00 |

| رگرسیون خطی چندگانه (تمرین) | 18:03 |

| رگرسیون سلسله مراتبی | 7:30 |

| رگرسیون باثبات یا رگرسیون مقاوم (Robust Regression) در R | 15:39 |

| میانگین درصد مطلق خطا (MAPE) در R | 11:44 |

| میانگین درصد مطلق خطای متقارن (SMAPE) در R | 5:44 |

| میانگین وزنی درصد مطلق خطا (WMAPE) در R | 7:08 |

| میانگین خطای مطلق در R | 7:44 |

| نحوه انجام پیش بینی Naive در R | 5:13 |

| مورد کاوی رگرسیون خطی ساده | 30:45 |

| مورد کاوی رگرسیون خطی چندگانه | 14:13 |

8. فصل هشتم: تحلیل عاملی

| عنوان جلسه | تایم جلسه |

| درباره تحلیل عاملی بیشتر بدانیم | 19:47 |

| تست کرویت بارتلت | 5:39 |

| تحلیل عاملی در R | 26:20 |

| تحلیل مولفه های اصلی با کتابخانه JMV | 17:30 |

| PCA با کتابخانه JMV | 9:15 |

| تحلیل عاملی اکتشافی با کتابخانه JMV | 18:10 |

| تحلیل عاملی تاییدی با کتابخانه JMV | 38:05 |

| ترسیم دیاگرام برای عاملی تاییدی با کتابخانه JMV | 10:05 |

9. فصل نهم: تحلیل واریانس در R

| عنوان جلسه | تایم جلسه |

| تحلیل واریانس چیست؟ | 3:43 |

| واریانس یکراهه در R | 22:46 |

| آموزش آزمون Brown–Forsythe در R | 20:29 |

| تست بارتلت در R | 6:09 |

| واریانس دوراهه در R | 21:20 |

| آموزش واریانس سه طرفه در R | 28:11 |

| آموزش دیتا فریم ویژه طرح های مقایسه ای (واریانس و کوواریانس) | 24:03 |

| آزمون تعقیبی و مقایسه زوجی پس از تجربه در R | 2:42 |

| آزمون توکی یا تست Tukey برای آزمون های تعقیبی | 11:54 |

| آموزش آزمون بونفرونی در R | 13:07 |

| آموزش آزمون Scheffe در R | 15:52 |

| آزمون تعقیبی Holm در R | 10:39 |

| آزمون KPSS در R | 12:55 |

| آموزش حداقل اختلاف معنی دار (LSD) | 16:55 |

| آزمون دونت در R | 4:48 |

| تحلیل واریانس ولچ (روش ANOVA Welch) | 12:18 |

| تحلیل واریانس دو طرفه : تمرین مجدد | 5:48 |

| تحلیل دو راهه (تمرین) | 13:48 |

| تحلیل مانوا در R | 25:40 |

| تحلیل واریانس یکراهه (تمرین) | 25:12 |

| تحلیل واریانس یکراهه (تمرین جدید) | 9:31 |

| تحلیل واریانس چند متغیره | 6:26 |

| محاسبه مقدار مربع اتا (Eta Squared) در R برای اندازه اثر | 8:35 |

| آموزش واریانس گام به گام در R | 9:33 |

| آموزش آزمون من کندال در R | 6:19 |

| تحلیل واریانس با اندازه گیری مکرر در R | 17:05 |

| تحلیل واریانس با استفاده از کتابخانه JMV | 57:22 |

| جمع بندی تحلیل واریانس در R | 43:48 |

10. فصل دهم : تحلیل کوواریانس در R

| عنوان جلسه | تایم جلسه |

| تحلیل کوواریانس چیست؟ | 6:14 |

| فرق کوواریانس با واریانس | 1:28 |

| کوواریانس یکراهه | 34:20 |

| کوواریانس دوراهه | 22:10 |

| کوواریانس چند متغیره | 30:39 |

| تمرین تحلیل کوواریانس با R | 7:51 |

| تجزیه و تحلیل داده های اکتشافی در R | 22:37 |

| جمع بندی و گزارش نویسی کوواریانس در R | 31:41 |

11. فصل یازدهم: رگرسیون غیر خطی و لجستیک

| عنوان جلسه | تایم جلسه |

| رگرسیون غیر خطی و لجستیک چیست؟ | 2:24 |

| رگرسیون لجستیک دوجمله ای | 12:29 |

| تفسیر خروجی رگرسیون لجستیک | 7:22 |

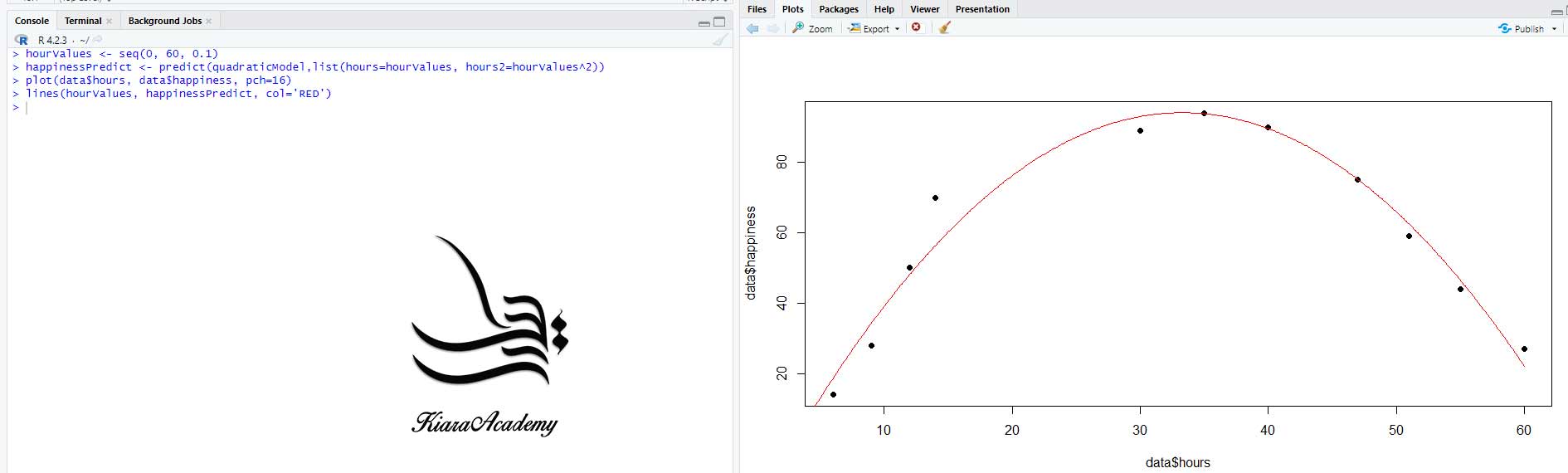

| رگرسیون درجه دوم در R | 14:31 |

| رگرسیون تکه ای (Piecewise Regression) | 17:24 |

| رگرسیون چندکی | 10:02 |

| رگرسیون Spline در R | 10:03 |

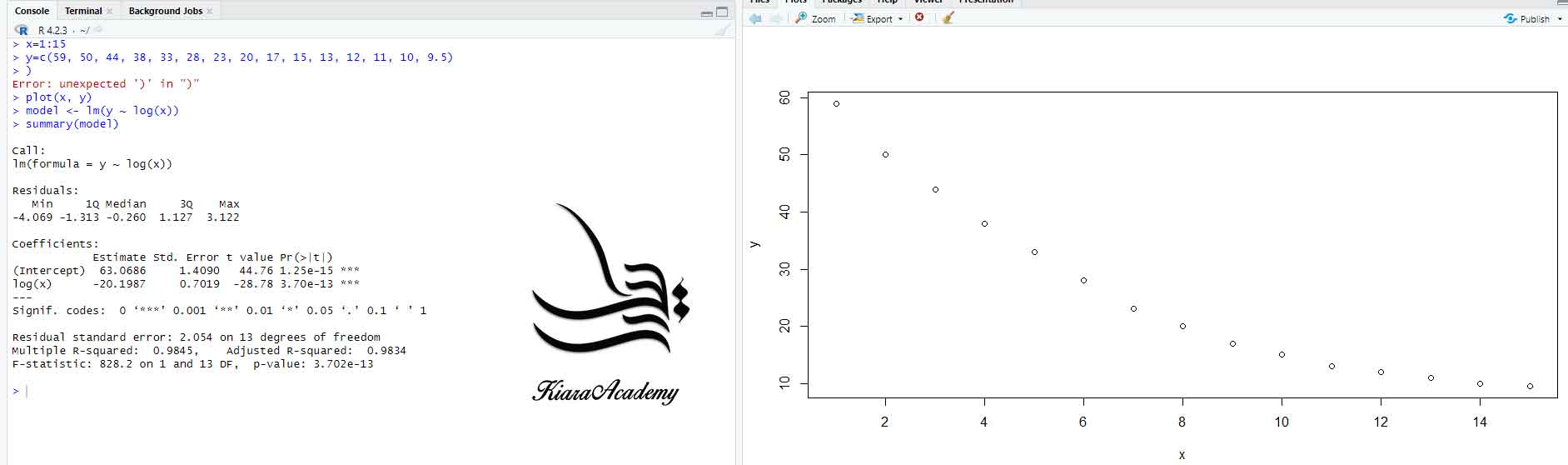

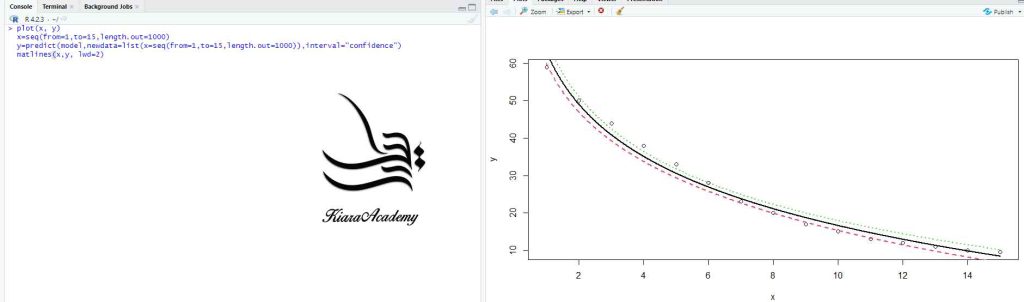

| رگرسیون لگاریتمی در R | 4:07 |

| رگرسیون نمایی در R | 5:50 |

| رگرسیون توانی (Power Regression) در R | 4:18 |

| رگرسیون حداقل مربعات وزنی در R | 9:59 |

| ضریب همبستگی متیوز در R | 9:21 |

12. فصل دوازدهم: بررسی متغیرهای سوم (میانجی و تعدیل کننده)

| عنوان جلسه | تایم جلسه |

| متغیر میانجی و تعدیل کننده چیست؟ | 6:24 |

| تحلیل مسیر در R: جلسه 1 | 12:59 |

| تحلیل مسیر در R: جلسه بررسی متغیر میانجی | 10:32 |

| بررسی متغیر میانجی با کتابخانه medmod | 11:06 |

| بررسی آزمون سوبل برای معنی داری متغیر میانجی | 10:42 |

| بررسی روابط مسیر با کتابخانه JAMM | 25:38 |

| بررسی متغیر میانجی با کتابخانه JAMM | 10:33 |

| بررسی متغیر تعدیل کننده با کتابخانه medmod | 8:51 |

13. فصل سیزدهم: روش های ناپارامتریک در R

| عنوان جلسه | تایم جلسه |

| آمار ناپارامتریک چیست؟ | 4:37 |

| آموزش آزمون کروسکال-والیس در R | 11:15 |

| آزمون مک نمار (McNemar’s Test) | 15:13 |

| آزمون یو من ویتنی (Mann-Whitney U) | 21:01 |

| آموزش تست دان در R | 6:30 |

| آزمون خی دو برای استقلال | 9:19 |

| آزمون خی دو برای برازش | 20:19 |

| بررسی اندازه اثر در آزمون خی دو | 6:58 |

| آزمون فریدمن (Friedman) | 13:09 |

| تست ویلکاکسون | 19:38 |

| تست کروسکال-والیس در R (تمرین مجدد) | 9:20 |

| تست مک نمار (تمرین مجدد) | 5:16 |

| آمار ناپارامتریک با کتابخانه JAMM | 19:58 |

| جمع بندی و گزارش نویسی آمار ناپارامتریک | 34:11 |

14. فصل چهاردهم: تحلیل خوشه ای یا کلاستر

| عنوان جلسه | تایم جلسه |

| تحلیل کلاستر و تحلیل خوشه ای (Cluster Analysis) | 6:22 |

| اجرای تحلیل کلاستر در R | 30:44 |

15. فصل پانزدهم: آزمون های تشخیصی

| عنوان جلسه | تایم جلسه |

| آزمون های تشخیصی چیست؟ | 8:36 |

| اجرای آزمون تشخیصی در R | 40:22 |

| عنوان جلسه | تایم جلسه |

| محاسبه ضریب جینی | 5:51 |

| عنوان جلسه | تایم جلسه |

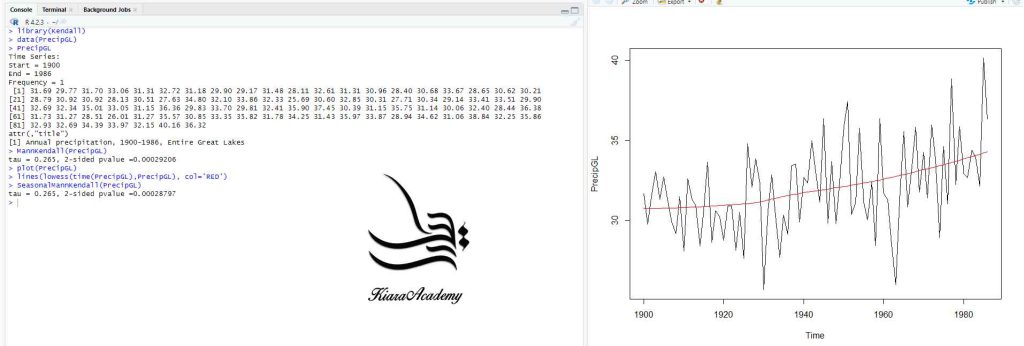

| اجرای ابتدایی سری زمانی | 21:49 |

| میانگین متحرک نمایی (EMA) در R | 15:19 |

| نمودار سری زمانی | 4:00 |

18.فصل هجدهم: ترسیم نمودارهای آماری در R

| عنوان جلسه | تایم جلسه |

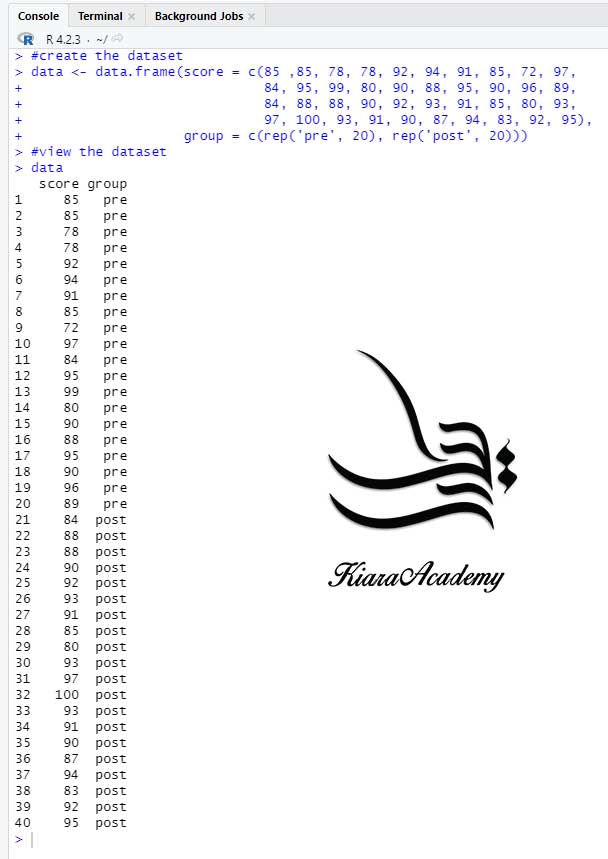

| ترسیم نمودار پراکندگی Scatter Plot در R | 3:45 |

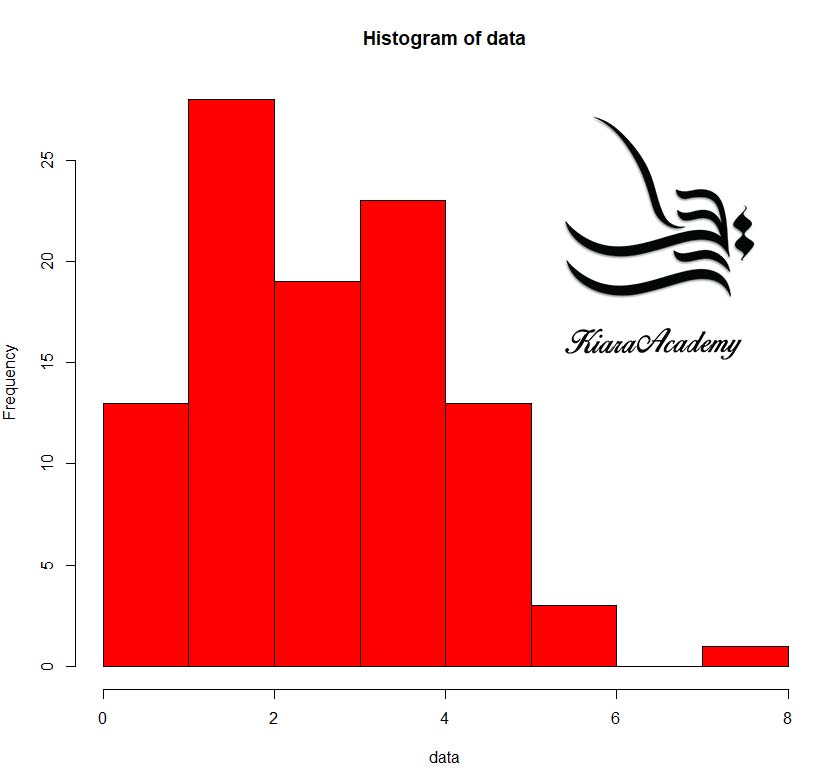

| ترسیم نمودار هیستگرام در R | 7:29 |

| ترسیم نمودار دایره ای در R | 11:04 |

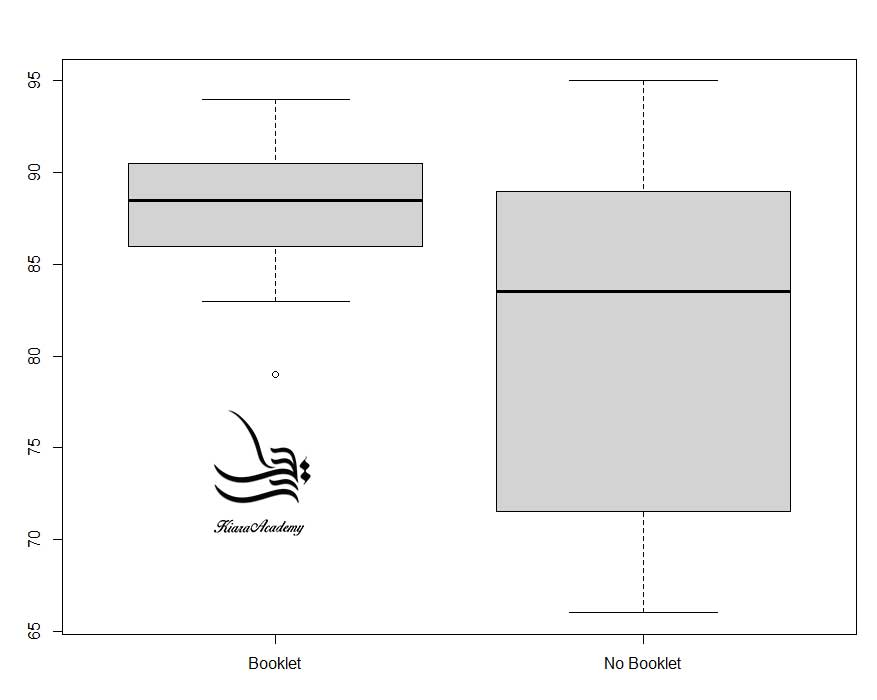

| ترسیم نمودار جعبه ای در R | 15:03 |

| ترسیم نمودار SURVEY در R | 4:06 |

| ترسیم نمودار DOT در R | 4:50 |

| ترسیم نمودار میله ای در R | 6:12 |

| ترسیم نمودار میله ای خوشه ای در R | 11:57 |

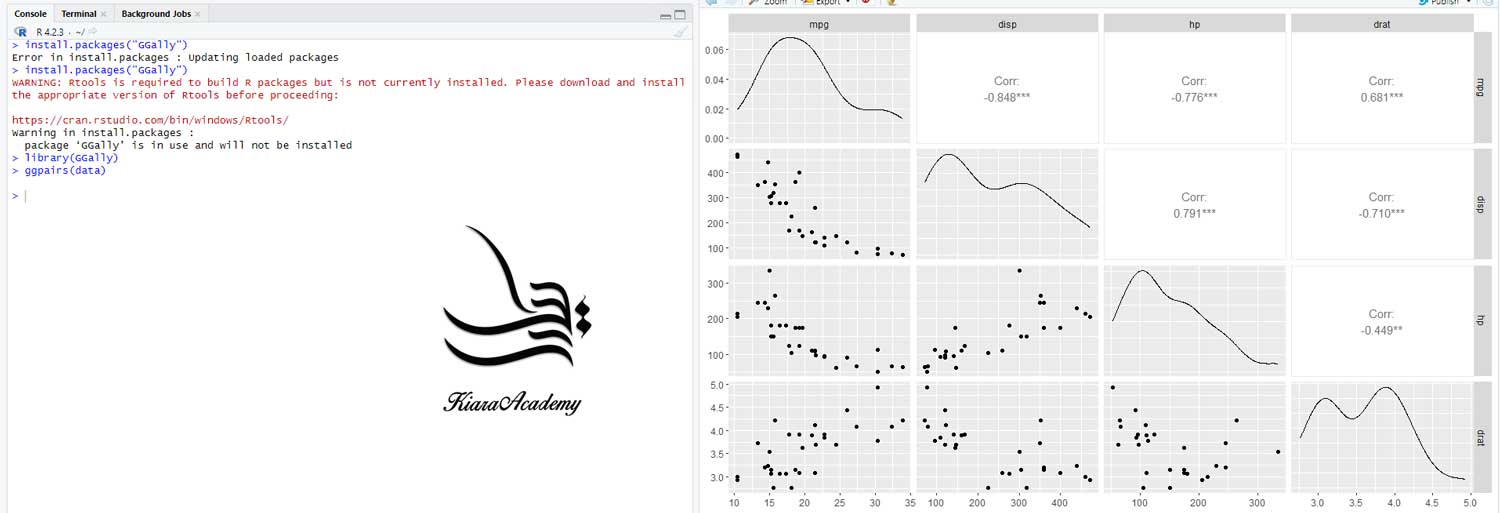

| آموزش ترسیم نمودار با پکیج ggplot | 23:04 |

| مصورسازی داده با ggplot2 | 7:58 |

| ترسیم نمودار با SPSS | 6:19 |

| ترسیم نمودار با STATA | 3:33 |

| ترسیم نمودار با JASP | 4:38 |

| ترسیم نمودار با Jamovi | 4:44 |

19.فصل نوزدهم: کتابخانه ها برای توسعه در R

| عنوان جلسه | تایم جلسه |

| ایجاد وب و اپلیکیشن با Shiny | 6:36 |

بهترین دوره آموزش R

تجزیه و تحلیل آماری داده ها با استفاده از زبان برنامه نویسی R

این دوره نحوه انجام تعدادی تست های آماری را با استفاده از R را آموزش می دهد. علم داده یک رشته هیجان انگیز است که به شما امکان می دهد داده های خام را به درک، بینش و دانش تبدیل کنید. هدف “دوره آموزش R ” این است که به شما کمک کند مهم ترین ابزارهایی را در R یاد بگیرید که به شما امکان انجام علم داده را می دهد.

آموزش تحلیل آماری با نرم افزار R

ابتدا باید دادههای خود را به R وارد کنید. این کار معمولاً به این معنی است که دادههای ذخیره شده در یک فایل، پایگاه داده یا رابط برنامهنویسی برنامه وب (API) را میگیرید و آن را در یک قاب داده در R بارگیری میکنید. اگر نمیتوانید دادههای خود را دریافت کنید در R، شما نمی توانید علم داده را روی آن انجام دهید! هنگامی که داده های خود را وارد کردید، ایده خوبی است که آن ها را مرتب کنید. مرتب کردن دادههای شما به معنای ذخیره آنها به شکلی ثابت است که معنایی مجموعه داده را با نحوه ذخیرهسازی آن مطابقت دهد. به طور خلاصه، وقتی داده های شما مرتب هستند، هر ستون یک متغیر و هر ردیف یک مشاهده است. دادههای مرتب مهم هستند زیرا ساختار ثابت به شما امکان میدهد مبارزه خود را روی سؤالات مربوط به دادهها متمرکز کنید، نه مبارزه برای دریافت دادهها به شکل مناسب برای عملکردهای مختلف.

هنگامی که داده های مرتبی دارید، اولین قدم متداول تغییر آن است. تغییر شکل شامل محدود کردن مشاهدات مورد علاقه (مانند همه افراد در یک شهر یا همه دادههای سال گذشته)، ایجاد متغیرهای جدید که تابعی از متغیرهای موجود هستند (مانند محاسبه سرعت از راه دور و زمان)، و محاسبه مجموعهای از خلاصهها است. آمار (مانند شمارش یا میانگین). هنگامی که داده های مرتبی را با متغیرهای مورد نیاز دارید، دو موتور اصلی تولید دانش وجود دارد:

- تجسم

- مدل سازی

این ها دارای نقاط قوت و ضعف مکمل هستند، بنابراین هر تحلیل واقعی بارها بین آنها تکرار می شود.

- تجسم اساساً یک فعالیت انسانی است. یک تجسم خوب چیزهایی را به شما نشان می دهد که انتظارش را نداشتید یا سؤالات جدیدی در مورد داده ها ایجاد می کند. یک تجسم خوب همچنین ممکن است به این نکته اشاره کند که شما سؤال اشتباهی میپرسید یا باید دادههای مختلفی را جمعآوری کنید. تجسمسازیها میتوانند شما را شگفتزده کنند، اما بهخوبی مقیاسبندی نمیشوند، زیرا نیاز به تفسیر آنها توسط انسان دارند.

- مدلها ابزارهای مکمل تجسم هستند. هنگامی که سوالات خود را به اندازه کافی دقیق کردید، می توانید از یک مدل برای پاسخ به آنها استفاده کنید. مدل ها اساساً یک ابزار ریاضی یا محاسباتی هستند، بنابراین به طور کلی مقیاس خوبی دارند. حتی وقتی این کار را نمی کنند، معمولاً خرید رایانه های بیشتر از خرید مغزهای بیشتر ارزان تر است! اما هر مدلی مفروضاتی را مطرح می کند و به دلیل ماهیت خود یک مدل نمی تواند مفروضات خود را زیر سوال ببرد. این بدان معناست که یک مدل اساسا نمی تواند شما را شگفت زده کند.

چرا R را یاد بگیریم؟

درست است که منحنی یادگیری ممکن است تندتر از نرم افزارهای دیگر باشد، اما با R، نتایج تجزیه و تحلیل شما متکی به به خاطر سپردن متوالی اشاره و کلیک نیست، بلکه بر روی یک سری دستورات نوشته شده است، و این چیز خوبی است! بنابراین، اگر میخواهید تجزیه و تحلیل خود را دوباره انجام دهید، زیرا دادههای بیشتری را جمعآوری کردهاید، لازم نیست به خاطر بیاورید که بر روی کدام دکمه کلیک کردهاید تا نتایج خود را به دست آورید، فقط باید اسکریپت خود را دوباره اجرا کنید.

کار با اسکریپت ها مراحلی را که در تجزیه و تحلیل خود استفاده کرده اید واضح می کند و کدی که می نویسید می تواند توسط شخص دیگری که می تواند به شما بازخورد بدهد و اشتباهات را تشخیص دهد بررسی شود. کار با اسکریپت ها شما را مجبور می کند که درک عمیق تری از کاری که انجام می دهید داشته باشید و یادگیری و درک شما از روش هایی را که استفاده می کنید تسهیل می کند.

- R با بیش از 10000 بسته قابل نصب برای گسترش قابلیتهای خود، چارچوبی را ارائه میکند که به شما امکان میدهد رویکردهای آماری بسیاری از رشتههای علمی را ترکیب کنید تا به بهترین وجه با چارچوب تحلیلی مورد نیاز برای تجزیه و تحلیل دادههای خود مطابقت داشته باشد. به عنوان مثال، R دارای بسته هایی برای تجزیه و تحلیل تصویر، GIS، سری های زمانی، ژنتیک جمعیت و بسیاری موارد دیگر است.

- R بر روی داده های هر شکل و اندازه کار می کند. مهارت هایی که با مقیاس R به راحتی با اندازه مجموعه داده خود یاد می گیرید. اینکه مجموعه داده شما صدها یا میلیون ها خط داشته باشد، برای شما تفاوت چندانی نخواهد داشت. R برای تجزیه و تحلیل داده ها طراحی شده است. دارای ساختارهای داده و انواع داده های خاص است که مدیریت داده های از دست رفته و عوامل آماری را راحت می کند. R میتواند به صفحات گسترده، پایگاههای داده و بسیاری از فرمتهای داده دیگر در رایانه یا وب متصل شود.

- R گرافیک باکیفیت تولید می کند. عملکردهای رسم در R بی پایان هستند و به شما این امکان را می دهند که هر جنبه ای از نمودار خود را تنظیم کنید تا پیام داده های خود را به بهترین نحو منتقل کنید.

- روزانه هزاران نفر از R استفاده می کنند. بسیاری از آنها مایلند از طریق لیست های پستی و وب سایت هایی مانند Stack Overflow یا در انجمن RStudio به شما کمک کنند.

3.2.7 نه تنها R رایگان است، بلکه منبع باز نیز می باشد. - هر کسی می تواند کد منبع را بررسی کند تا ببیند R چگونه کار می کند. به دلیل این شفافیت، احتمال اشتباهات کمتری وجود دارد، و اگر شما (یا شخص دیگری) برخی از آنها را پیدا کرد، می توانید گزارش دهید و اشکالات را برطرف کنید.

علم داده با R

آخرین مرحله علم داده، ارتباط است، بخش کاملاً حیاتی هر پروژه تجزیه و تحلیل داده. فرقی نمیکند که مدلها و تجسمهای شما چقدر شما را به درک دادهها سوق دادهاند، مگر اینکه بتوانید نتایج خود را به دیگران نیز منتقل کنید. اطراف همه این ابزارها برنامه نویسی است. برنامه نویسی یک ابزار مقطعی است که در هر قسمت از پروژه از آن استفاده می کنید. برای اینکه یک دانشمند داده باشید نیازی نیست که یک برنامه نویس خبره باشید، اما یادگیری بیشتر در مورد برنامه نویسی نتیجه می دهد زیرا تبدیل شدن به یک برنامه نویس بهتر به شما امکان می دهد کارهای معمول را خودکار کنید و مشکلات جدید را با سهولت بیشتری حل کنید.

تایید فرضیه با استفاده از R

میتوان تجزیه و تحلیل دادهها را به دو دسته تقسیم کرد:

- تولید فرضیه

- تأیید فرضیه (گاهی اوقات تحلیل تأییدی نامیده میشود)

مکمل ایجاد فرضیه، تأیید فرضیه است. تایید فرضیه به دو دلیل دشوار است: برای ایجاد پیشبینیهای ابطالپذیر، به یک مدل ریاضی دقیق نیاز دارید. این اغلب به پیچیدگی آماری قابل توجهی نیاز دارد. برای تایید یک فرضیه فقط یک بار می توانید از مشاهده استفاده کنید. به محض اینکه بیش از یک بار از آن استفاده کردید، دوباره به تجزیه و تحلیل اکتشافی باز می گردید. این بدان معناست که برای تأیید فرضیه باید طرح تحلیل خود را «پیش ثبت نام» (از قبل بنویسید) و حتی زمانی که داده ها را دیده اید از آن منحرف نشوید. معمولاً در مورد مدل سازی به عنوان ابزاری برای تأیید فرضیه و تجسم به عنوان ابزاری برای تولید فرضیه فکر می کنیم.

آموزش کامل RStudio

RStudio یک محیط توسعه یکپارچه یا IDE برای برنامه نویسی R است. آن را از http://www.rstudio.com/download دانلود و نصب کنید. RStudio چند بار در سال به روز می شود. زمانی که نسخه جدیدی در دسترس باشد، RStudio به شما اطلاع خواهد داد. هنگامی که RStudio را راه اندازی می کنید، دو منطقه کلیدی را در رابط مشاهده خواهید کرد: در حال حاضر، تنها چیزی که باید بدانید این است که کد R را در پنل کنسول تایپ کرده و Enter را فشار دهید تا اجرا شود. با پیش رفتن بیشتر خواهید آموخت!

در R چه کتابخانه هایی را نصب کنیم؟

همچنین باید چند بسته R را نصب کنید. بسته R مجموعه ای از توابع، داده ها و مستنداتی است که قابلیت های پایه R را گسترش می دهد. استفاده از بسته ها کلید موفقیت آمیز استفاده از R است.

- بستههای موجود در Tidyverse

میتوانید با یک خط کد، Tidyverse کامل را نصب کنید:

| install.packages (“tidyverse”) |

خط کد را در کنسول تایپ کنید و سپس اینتر را فشار دهید تا اجرا شود. R بسته ها را از CRAN دانلود کرده و روی رایانه شما نصب می کند. اگر در نصب مشکل دارید، مطمئن شوید که به اینترنت متصل هستید و https://cloud.r-project.org/ توسط فایروال یا پروکسی شما مسدود نشده است. شما نمی توانید از توابع، اشیاء و فایل های راهنما در یک بسته استفاده کنید تا زمانی که آن را با() library بارگذاری کنید. هنگامی که یک بسته را نصب کردید، می توانید آن را با تابع () library بارگذاری کنید:

| library(tidyverse) #> ── Attaching packages ─────────────────────────────────────── tidyverse 1.3.2 ── #> ✔ ggplot2 3.4.0 ✔ purrr 0.3.5 #> ✔ tibble 3.1.8 ✔ dplyr 1.0.10 #> ✔ tidyr 1.2.1 ✔ stringr 1.4.1 #> ✔ readr 2.1.3 ✔ forcats 0.5.2 #> ── Conflicts ────────────────────────────────────────── tidyverse_conflicts() ── #> ✖ dplyr::filter() masks stats::filter() #> ✖ dplyr::lag() masks stats::lag() |

به شما می گوید که tidyverse بسته های ggplot2، tibble، tidyr، reader، purrr و dplyr را بارگذاری می کند. این ها هسته اصلی نظم و ترتیب در نظر گرفته می شوند زیرا تقریباً در هر تحلیلی از آنها استفاده خواهید کرد. بستهها در جهان مرتب تغییر میکنند. با اجرای () tidyverse_update.

بسیاری از بسته های عالی دیگر وجود دارند که بخشی از نظم و ترتیب نیستند، زیرا آنها مشکلات را در حوزه متفاوتی حل می کنند، یا با مجموعه ای متفاوت از اصول اساسی طراحی شده اند. این آنها را بهتر یا بدتر نمی کند، فقط متفاوت هستند. به عبارت دیگر، مکمل thedyverse، messyverse نیست، بلکه بسیاری از جهانهای بستههای مرتبط به هم هستند. همانطور که پروژههای علوم داده بیشتری را با R انجام میدهید، بستههای جدید و روشهای جدید تفکر در مورد دادهها را یاد خواهید گرفت.

| install.packages(c(“nycflights13″، “gapminder”، “Lahman”)) |

آموزش اجرای کد در R

مثلا این کد را اجرا می کنیم:

| 1 + 2 #> [1] 3 |

اگر همان کد را در کنسول خود اجرا کنید، به شکل زیر خواهد بود:

| > 1 + 2 [1] 3 |

دو تفاوت اصلی وجود دارد. در کنسول خود، پس از >، به نام prompt، تایپ می کنید. ما دستور را در کتاب نشان نمی دهیم. در کتاب، خروجی با #> توضیح داده شده است. در کنسول شما مستقیماً بعد از کد شما ظاهر می شود. این دو تفاوت بدین معناست که اگر با نسخه الکترونیکی کتاب کار میکنید، میتوانید به راحتی کد را از کتاب و داخل کنسول کپی کنید.

- توابع در یک فونت کد و به دنبال پرانتز هستند، مانند sum() یا mean().

- سایر اشیاء R (مانند آرگومان های داده یا تابع) در فونت کد، بدون پرانتز، مانند پروازها یا x هستند.

- هرچه کد شما کوتاه تر باشد، درک آن آسان تر و رفع آن آسان تر است.

چگونه با RStudio کار کنیم؟

اصطلاح R برای اشاره به زبان برنامه نویسی و نرم افزاری که اسکریپت های نوشته شده با استفاده از آن را تفسیر می کند استفاده می شود. RStudio در حال حاضر یک روش بسیار محبوب برای نه تنها نوشتن اسکریپت های R بلکه برای تعامل با نرم افزار R است. برای عملکرد صحیح، RStudio به R نیاز دارد و بنابراین هر دو باید روی رایانه شما نصب شوند. محصول منبع باز RStudio IDE تحت مجوز عمومی عمومی Affero (AGPL) نسخه 3 رایگان است. RStudio IDE همچنین با مجوز تجاری و پشتیبانی ایمیل اولویت دار از RStudio, Inc در دسترس است. از RStudio برای نوشتن کد، پیمایش فایلها در رایانهمان، بررسی متغیرهایی که میخواهیم ایجاد کنیم، استفاده میکنیم و نمودارهایی را که تولید میکنیم تجسم میکنیم. RStudio همچنین میتواند برای موارد دیگری (مانند کنترل نسخه، توسعه بستهها، نوشتن برنامهها) استفاده شود.

RStudio به 4 «پنجره» تقسیم میشود:

- منبع اسکریپتها و اسناد شما (بالا سمت چپ، در طرحبندی پیشفرض)

- کنسول R (پایین سمت چپ)

- محیط/تاریخچه (بالا سمت راست)

- و فایلها/ توطئه ها / بسته ها / کمک / بیننده (پایین سمت راست)

قرار دادن این صفحات و محتوای آن ها را می توان سفارشی کرد (به منو، ابزارها -> گزینه های جهانی -> طرح بندی پانل مراجعه کنید). یکی از مزایای استفاده از RStudio این است که تمام اطلاعاتی که برای نوشتن کد نیاز دارید در یک پنجره واحد موجود است. علاوه بر این، با بسیاری از میانبرها، تکمیل خودکار، و برجسته کردن انواع فایل های اصلی که در حین توسعه در R استفاده می کنید، RStudio تایپ را آسان تر و کمتر مستعد خطا می کند.

RStudio مجموعهای از ابزارهای مفید را برای انجام این کار از طریق رابط «پروژهها» خود ارائه میکند، که نه تنها یک فهرست کاری برای شما ایجاد میکند، بلکه مکان آن را نیز به خاطر میآورد (به شما امکان میدهد به سرعت به آن پیمایش کنید) و به صورت اختیاری تنظیمات سفارشی و فایلهای باز را حفظ میکند. از سرگیری کار بعد از استراحت راحت تر است. در زیر، ما مراحل ایجاد “پروژه R” را برای این آموزش طی خواهیم کرد.

برای تحلیل داده با R چه چیزهایی یاد بگیرم؟

- RStudio را باز کنید

- در منوی File روی New project کلیک کنید، New directory و سپس New project را انتخاب کنید

- یک نام برای این پوشه جدید (یا «دایرکتوری») وارد کنید و یک مکان مناسب برای آن انتخاب کنید. این فهرست راهنمای کاری شما برای بقیه روز خواهد بود (به عنوان مثال، ~/data-carpentry)

- روی Create project کلیک کنید

- در زیر تب Files در سمت راست صفحه، روی New Folder کلیک کنید و یک پوشه به نام داده در فهرست کاری تازه ایجاد شده خود ایجاد کنید (به عنوان مثال، ~/data-carpentry/data)

چگونه در R برنامه نویسی کنیم؟

اساس برنامه نویسی این است که دستورالعمل هایی را می نویسیم که کامپیوتر باید آن ها را دنبال کند و سپس به کامپیوتر می گوییم که این دستورالعمل ها را دنبال کند. ما دستورالعمل ها را در R می نویسیم یا کد می کنیم زیرا این زبان یک زبان مشترک است که هم کامپیوتر و هم ما می توانیم آن را بفهمیم. ما دستورات را فراخوانی می کنیم و به رایانه می گوییم که با اجرای آن دستورات (که در حال اجرا نیز نامیده می شود) دستورالعمل ها را دنبال کند. دو راه اصلی برای تعامل با R وجود دارد:

- با استفاده از کنسول یا استفاده از فایلهای اسکریپت (فایلهای متنی ساده که حاوی کد شما هستند).

- صفحه کنسول (در RStudio، پانل پایین سمت چپ) جایی است که دستورات نوشته شده به زبان R را می توان بلافاصله توسط کامپیوتر تایپ و اجرا کرد.

- همچنین جایی است که نتایج برای دستورات اجرا شده نشان داده می شود.

- میتوانید دستورات را مستقیماً در کنسول تایپ کنید و Enter را فشار دهید تا آن دستورات را اجرا کنید، اما وقتی جلسه را ببندید فراموش میشوند.

چون می خواهیم کد و گردش کار ما قابل تکرار باشد، بهتر است دستورات مورد نظر خود را در ویرایشگر اسکریپت تایپ کنیم و اسکریپت را ذخیره کنیم. به این ترتیب، یک رکورد کامل از کارهایی که ما انجام دادیم وجود دارد، و هر کسی (از جمله خود آینده ما!) می تواند به راحتی نتایج را در رایانه خود تکرار کند.

- RStudio به شما اجازه می دهد تا با استفاده از میانبر Ctrl + Enter دستورات را مستقیماً از ویرایشگر اسکریپت اجرا کنید (در مک، Cmd + Return نیز کار می کند).

- دستور روی خط فعلی در اسکریپت (که توسط مکان نما مشخص شده است) یا تمام دستورات موجود در متن انتخاب شده فعلی به کنسول ارسال می شود و با فشار دادن Ctrl + Enter اجرا می شود.

اگر R آماده پذیرش دستورات باشد، کنسول R یک اعلان > را نشان می دهد. اگر دستوری را دریافت کرد (با تایپ کردن، کپی پیست یا ارسال از ویرایشگر اسکریپت با استفاده از Ctrl + Enter)، R سعی میکند آن را اجرا کند و پس از آماده شدن، نتایج را نشان میدهد و با یک > جدید باز میگردد تا دستورات جدید منتظر بماند.

R همچنان منتظر است تا داده های بیشتری را وارد کنید زیرا هنوز کامل نشده است، کنسول یک اعلان + نشان می دهد. به این معنی است که شما وارد کردن یک دستور کامل را تمام نکرده اید. این به این دلیل است که شما یک پرانتز یا نقل قول را «بستهاید»، یعنی تعداد پرانتز چپ به اندازه پرانتز راست، یا همان تعداد علامت نقل قول باز و بسته را ندارید. هنگامی که این اتفاق افتاد و فکر کردید که تایپ دستور خود را به پایان رسانده اید، داخل پنجره کنسول کلیک کنید و Esc را فشار دهید. این دستور ناقص را لغو می کند و شما را به فرمان > باز می گرداند.

آموزش جامع آزمون های آماری در R

| hsb2 <- within(read.csv(“آدرس دیتا را وارد کنید”), {race <- as.factor(race) schtyp <- as.factor(schtyp) prog <- as.factor(prog) }) attach(hsb2) |

تی تک نمونه ای (One sample t-test) در R

آزمون t تک نمونه ای چیست؟ آزمون t تک نمونه ای یک آزمون فرضیه آماری است که برای تعیین اینکه آیا میانگین جامعه ناشناخته با یک مقدار خاص متفاوت است یا خیر. چه زمانی می توانم از آزمون استفاده کنم؟ می توانید از آزمون برای داده های پیوسته استفاده کنید. داده های شما باید یک نمونه تصادفی از یک جمعیت عادی باشد. اگر داده های من تقریباً به طور معمول توزیع نشده باشند، چه؟ اگر اندازه نمونه شما بسیار کوچک است، ممکن است نتوانید نرمال بودن را آزمایش کنید. ممکن است لازم باشد به درک خود از داده ها تکیه کنید. وقتی نمیتوانید با خیال راحت نرمال بودن را فرض کنید، میتوانید یک آزمایش ناپارامتریک را انجام دهید که نرمال بودن را فرض نمیکند.

چه چیزی نیاز داریم؟ برای آزمون t تک نمونه ای به یک متغیر نیاز داریم. ما همچنین یک ایده یا فرضیه داریم که میانگین جمعیت مقداری ارزش دارد. در اینجا دو نمونه وجود دارد:

یک بیمارستان یک نمونه تصادفی از اندازه گیری کلسترول برای مردان دارد. این بیماران برای مسائلی غیر از کلسترول ویزیت شدند. آنها هیچ دارویی برای کلسترول بالا مصرف نمی کردند. بیمارستان می خواهد بداند که آیا میانگین کلسترول ناشناخته برای بیماران با سطح هدف 200 میلی گرم متفاوت است یا خیر. ما گرم پروتئین را برای نمونه ای از میله های انرژی اندازه گیری می کنیم. برچسب ادعا می کند که میله ها 20 گرم پروتئین دارند. ما می خواهیم بدانیم که آیا برچسب ها درست هستند یا نه.

مفروضات آزمون t تک نمونه ای: برای یک تست معتبر، به مقادیر داده نیاز داریم که عبارتند از:

- مستقل (ارزش ها به یکدیگر مرتبط نیستند).

- از طریق یک نمونه تصادفی ساده از جامعه به دست آمد.

- همچنین، جمعیت به طور معمول توزیع شده است.

اگر بخواهید تی تک نمونه ای (One sample t-test) را اجرا کنید :

| t.test(write, mu = 50) |

| ## ## One Sample t-test ## ## data: write ## t = 4.14, df = 199, p-value = 5.121e-05 ## alternative hypothesis: true mean is not equal to 50 ## 95 percent confidence interval: ## 51.5 54.1 ## sample estimates: ## mean of x ## 52.8 |

اجرای آزمون One sample median test در R

آزمون میانه یک نمونه چیست؟ آزمون میانه یک نمونه بررسی می کند که آیا تفاوت معنی داری بین میانه فرضی ما و میانه واقعی یک نمونه وجود دارد یا خیر. دو آزمون میانه یک نمونه وجود دارد، آزمون رتبه Wicloxon و آزمون Sign. هر دو تست ساده و آسان برای اجرا هستند. نکته کلیدی این است که شما باید فرضیه را برای مقدار میانگین مورد انتظار قبل از اجرای تجزیه و تحلیل، به صورت پیشینی انتخاب کنید.

آزمون علامت یک آزمون ناپارامتریک عمومی خوب است که مفروضات (نیازمندی) بسیار کمی دارد اما قدرت محدودی دارد. برای استفاده از آزمون علامت فقط باید بدانید که هر جفت نقطه داده (مشاهدات) مرتب شده اند، به عنوان مثال x > y. اگر می توان به تمام نقاط داده شما (همه مشاهدات شما) یک مقدار رتبه > مقداری مانند اول، دوم، سوم و ….داده شود و اگر توزیع متقارن دارید، می توان از آزمون رتبه علامت دار Wilcoxon استفاده کرد. بنابراین، از آنجایی که با مفروضات بیشتری شروع میشود، آزمون رتبهبندی علامتدار Wilcoxon خاصتر است و تمرکز محدودتری دارد. اما همچنین (معمولا) قدرت بیشتری در یافتن تفاوت ها نسبت به آزمون علائم عمومی تر دارد.

| wilcox.test(write, mu = 50) |

| ## ## Wilcoxon signed rank test with continuity correction ## ## data: write ## V = 13177, p-value = 3.702e-05 ## alternative hypothesis: true location is not equal to 50 |

اجرای آزمون Binomial test در R

آزمون دو جمله ای یک آزمون فرضیه است که زمانی استفاده می شود که یک متغیر مقوله ای با دو عبارت وجود داشته باشد، به عنوان مثال، جنسیت با مذکر و مؤنث. سپس آزمون دو جمله ای می تواند بررسی کند که آیا توزیع فرکانس متغیر با توزیع مورد انتظار مطابقت دارد، به عنوان مثال. مردان و زنان به طور مساوی نماینده دارند. نسبت زنان 54 درصد است. این یک مورد خاص زمانی است که می خواهید آزمایش کنید که آیا توزیع فرکانسی متغیرها تصادفی است یا خیر؟

در این حالت احتمال وقوع روی 50 درصد تنظیم می شود. بنابراین از آزمون دوجمله ای می توان برای آزمایش اینکه آیا توزیع فراوانی یک نمونه با جامعه یکسان است یا خیر استفاده می شود.

آزمون دوجمله ای بررسی می کند که آیا توزیع فراوانی یک متغیر با دو مقدار/دسته در نمونه با توزیع در جامعه مطابقت دارد یا خیر. فرضیه ها در آزمون دو جمله ای:

- فرضیه صفر: توزیع فراوانی نمونه با جامعه مطابقت دارد.

- فرضیه جایگزین: توزیع فراوانی نمونه با جامعه مطابقت ندارد.

بنابراین، فرضیه غیر جهت دار فقط وجود یا عدم وجود تفاوت را بررسی می کند، اما نه اینکه این تفاوت به کدام سمت می رود. در حالت دو طرفه، هدف این است که بررسی شود که آیا احتمال وقوع یک عبارت در نمونه بیشتر یا کمتر از درصد معین یا واقعی است. در این حالت، یک عبارت به عنوان “موفقیت” تعریف می شود و بررسی می شود که آیا “احتمال موفقیت” واقعی کوچکتر یا بزرگتر از نمونه است.

| prop.test(sum(female), length(female), p = 0.5) |

| ## ## 1-sample proportions test with continuity correction ## ## data: sum(female) out of length(female), null probability 0.5 ## X-squared = 1.45, df = 1, p-value = 0.2293 ## alternative hypothesis: true p is not equal to 0.5 ## 95 percent confidence interval: ## 0.473 0.615 ## sample estimates: ## p ## 0.545 |

اجرای آزمون Chi-square goodness of fit در R

خوب بودن آزمون کای دو چیست؟ آزمون خی دو (Χ2) خوب بودن برازش، آزمون خوبی برازش برای یک متغیر طبقهبندی است. خوب بودن برازش معیاری است که نشان می دهد یک مدل آماری چقدر با مجموعه ای از مشاهدات مطابقت دارد.

- هنگامی که خوبی تناسب بالا باشد، مقادیر مورد انتظار بر اساس مدل به مقادیر مشاهده شده نزدیک است.

- زمانی که خوبی تناسب کم باشد، مقادیر مورد انتظار بر اساس مدل با مقادیر مشاهده شده فاصله دارند.

مدلهای آماری که با آزمونهای کای دو برازش تحلیل میشوند، توزیعها هستند. آن ها می توانند هر توزیعی باشند، از ساده به اندازه احتمال برابر برای همه گروه ها، تا پیچیده مانند توزیع احتمال با پارامترهای زیادی.

آزمایش فرضیه:

آزمون کای دو خوب بودن برازش یک آزمون فرضیه است. این به شما امکان می دهد تا در مورد توزیع یک جامعه بر اساس یک نمونه نتیجه گیری کنید. با استفاده از آزمون مجذور کای خوب بودن برازش، می توانید آزمایش کنید که آیا خوب بودن برازش «به اندازه کافی خوب» است تا نتیجه بگیرید که جامعه از توزیع پیروی می کند. با آزمون مجذور کای خوبی برازش، می توانید سوالاتی از قبیل: آیا این نمونه از جامعه ای گرفته شده است که…

- نسبت مساوی لاک پشت های نر و ماده؟

- نسبت های مساوی از لوبیاهای ژله ای قرمز، آبی، زرد، سبز و بنفش؟

- 90 درصد افراد راست دست و 10 درصد چپ دست؟

- فرزندانی با احتمال مساوی برای به ارث بردن همه ترکیبات ژنوتیپی ممکن (یعنی ژن های نامرتبط)؟

- توزیع پواسون سیل در سال؟

- توزیع عادی قیمت نان؟

| chisq.test(table(race), p = c(10, 10, 10, 70)/100) |

| ## ## Chi-squared test for given probabilities ## ## data: table(race) ## X-squared = 5.03, df = 3, p-value = 0.1697 |

اجرای آزمون Two independent samples t-test در R

آزمون t دو نمونه ای چیست؟ آزمون t دو نمونه ای (همچنین به عنوان آزمون t نمونه های مستقل نیز شناخته می شود) روشی است که برای آزمایش اینکه آیا میانگین جمعیت مجهول دو گروه برابر است یا نه. آیا این همان تست A/B است؟ بله، از آزمون t دو نمونه ای برای تجزیه و تحلیل نتایج حاصل از آزمون های A/B استفاده می شود. چه زمانی می توانم از آزمون استفاده کنم؟ زمانی میتوانید از آزمون استفاده کنید که مقادیر دادههای شما مستقل هستند، بهطور تصادفی از دو جمعیت عادی نمونهگیری شدهاند و دو گروه مستقل دارای واریانس مساوی هستند.

اگر بیش از دو گروه داشته باشم چه می شود؟ از روش مقایسه چندگانه استفاده کنید. آنالیز واریانس (ANOVA) یکی از این روش ها است. سایر روشهای مقایسه چندگانه شامل آزمون توکی-کرامر برای همه تفاوتهای زوجی، تجزیه و تحلیل میانگینها (ANOM) برای مقایسه میانگینهای گروه با میانگین کلی یا آزمون دانت برای مقایسه میانگین هر گروه با میانگین کنترل است. اگر واریانس دو گروه من برابر نباشد چه؟ همچنان می توانید از آزمون t دو نمونه ای استفاده کنید. شما از تخمین متفاوتی از انحراف استاندارد استفاده می کنید.

اگر داده های من تقریباً به طور معمول توزیع نشده باشند، چه؟ اگر اندازه نمونه شما بسیار کوچک است، ممکن است نتوانید نرمال بودن را آزمایش کنید. ممکن است لازم باشد به درک خود از داده ها تکیه کنید. وقتی نمیتوانید با خیال راحت نرمال بودن را فرض کنید، میتوانید یک آزمایش ناپارامتریک را انجام دهید که نرمال بودن را فرض نمیکند.

| t.test(write ~ female) |

| ## ## Welch Two Sample t-test ## ## data: write by female ## t = -3.66, df = 170, p-value = 0.0003409 ## alternative hypothesis: true difference in means is not equal to 0 ## 95 percent confidence interval: ## -7.50 -2.24 ## sample estimates: ## mean in group 0 mean in group 1 ## 50.1 55.0 |

اجرای آزمون Wilcoxon-Mann-Whitney test در R

ماژول های آزمون فرضیه تکنیک هایی را برای آزمایش برابری میانگین ها در دو نمونه مستقل ارائه کردند. یک فرض اساسی برای استفاده مناسب از آزمونهای توصیفشده این بود که نتیجه پیوسته تقریباً به طور معمول توزیع شده بود یا اینکه نمونهها به اندازه کافی بزرگ بودند (معمولاً n1> 30 و n2> 30) برای توجیه استفاده از آنها بر اساس قضیه حد مرکزی. هنگام مقایسه دو نمونه مستقل زمانی که نتیجه به طور معمول توزیع نمی شود و نمونه ها کوچک هستند، یک آزمون ناپارامتریک مناسب است.

یک آزمون ناپارامتریک محبوب برای مقایسه نتایج بین دو گروه مستقل، آزمون Mann Whitney U است. آزمون Mann Whitney U، که گاهی به آن آزمون Mann Whitney Wilcoxon یا Wilcoxon Rank Sum Test می گویند، برای آزمایش اینکه آیا دو نمونه احتمالاً از یک جامعه مشتق می شوند (یعنی اینکه دو جمعیت شکل یکسانی دارند) استفاده می شود. برخی از محققین این آزمون را به عنوان مقایسه میانگین بین دو جمعیت تفسیر می کنند. به یاد بیاورید که آزمون پارامتریک میانگین ها (H0: μ1=μ2) را بین گروه های مستقل مقایسه می کند.

در مقابل، فرضیه های صفر و دو طرفه تحقیق برای آزمون ناپارامتریک به صورت زیر بیان می شود:

- H0: دو جمعیت در مقابل برابر هستند

- H1: این دو جمعیت برابر نیستند.

این آزمون اغلب به عنوان یک آزمون دو طرفه انجام میشود و بنابراین، فرضیه تحقیق نشان میدهد که جمعیتها بر خلاف جهتبندی مشخص، برابر نیستند. اگر علاقه به تشخیص تغییر مثبت یا منفی در یک جمعیت نسبت به جمعیت دیگر باشد، از فرضیه تحقیق یک طرفه استفاده می شود. روش آزمایش شامل ادغام مشاهدات از دو نمونه در یک نمونه ترکیبی، پیگیری اینکه هر مشاهده از کدام نمونه میآید، و سپس رتبهبندی به ترتیب از 1 تا n1+n2، از پایین ترین تا بالاترین رتبه بندی میشود.

| wilcox.test(write ~ female) |

| ## ## Wilcoxon rank sum test with continuity correction ## ## data: write by female ## W = 3606, p-value = 0.0008749 ## alternative hypothesis: true location shift is not equal to 0 |

اجرای آزمون Chi-square test در R

تست Chi-Square چیست؟ آزمون Chi-Square یک روش آماری برای تعیین تفاوت بین داده های مشاهده شده و مورد انتظار است. این آزمون همچنین می تواند برای تعیین اینکه آیا با متغیرهای طبقه بندی شده در داده های ما همبستگی دارد یا خیر استفاده می شود. این کمک می کند تا بفهمیم که آیا تفاوت بین دو متغیر طبقه بندی به دلیل شانس است یا رابطه بین آن ها.

تعریف تست Chi-Square: آزمون کای اسکوئر یک آزمون آماری است که برای مقایسه نتایج مشاهده شده و مورد انتظار استفاده می شود. هدف این آزمون شناسایی این است که آیا اختلاف بین داده های واقعی و پیش بینی شده به دلیل شانس است یا به دلیل پیوند بین متغیرهای مورد بررسی.

در نتیجه، آزمون کای اسکوئر یک انتخاب ایده آل برای کمک به درک و تفسیر ما از ارتباط بین دو متغیر طبقه بندی شده است. یک آزمون کای دو یا آزمون ناپارامتریک قابل مقایسه برای آزمون فرضیه ای در مورد توزیع یک متغیر طبقه ای مورد نیاز است. متغیرهای طبقهبندی که نشاندهنده دستههایی مانند حیوانات یا کشورها هستند، میتوانند اسمی یا ترتیبی باشند. آن ها نمی توانند توزیع نرمال داشته باشند زیرا فقط می توانند چند مقدار خاص داشته باشند.

| chisq.test(table(female, schtyp)) |

| ## ## Pearson’s Chi-squared test with Yates’ continuity correction ## ## data: table(female, schtyp) ## X-squared = 5e-04, df = 1, p-value = 0.9815 |

اجرای آزمون Fisher’s exact test در R

آزمون Fisher Exact احتمال بدست آوردن جدولی را که به دلیل شانس نمونه گیری قوی است، آزمایش می کند. کلمه “قوی” به عنوان نسبت مواردی که با بیشترین موارد مورب هستند تعریف می شود. آزمون دقیق فیشر معمولاً در تست های یک دنباله استفاده می شود. با این حال، می توان از آن به عنوان یک تست دو دنباله نیز استفاده کرد. گاهی اوقات به آن تست فیشر اروین می گویند. این نام به این دلیل است که در همان زمان توسط فیشر، ایروین و یتس در سال 1930 توسعه یافت. آزمون دقیق فیشر علاوه بر آزمون مجذور کای برای جدول 2X2 محاسبه میشود، زمانی که جدول از سلولی تشکیل شده باشد که تعداد فرکانسهای مورد انتظار آن کمتر از 5 باشد. اصطلاحات خاصی وجود دارد که به درک نظریه آزمون دقیق فیشر کمک می کند.

آزمون دقیق فیشر از فرمول زیر استفاده می کند:

p= ( ( a + b ) ! ( c + d ) ! ( a + c ) ! ( b + d ) ! ) / a ! b ! c ! d ! N !

در این فرمول، «a»، «b»، «c» و «d» فراوانی جداگانه جدول احتمالی 2X2 هستند و «N» فراوانی کل است. آزمون دقیق فیشر از این فرمول برای بدست آوردن احتمال ترکیب فرکانس هایی که در واقع به دست می آیند استفاده می کند. همچنین شامل یافتن احتمال هر ترکیب ممکن است که شواهد بیشتری از ارتباط را نشان می دهد. مفروضات خاصی وجود دارد که آزمون دقیق فیشر بر اساس آن ها است.

فرض بر این است که نمونه ای که از جامعه جمع آوری شده است به روش نمونه گیری تصادفی انجام می شود. این فرض نیز به طور کلی در تمام آزمون های معناداری فرض می شود. در آزمون دقیق فیشر، یک فرضیه جهت دار فرض می شود. فرضیه جهت دار فرض شده چیزی جز فرضیه مبتنی بر آزمون یک دنباله نیست. به عبارت دیگر، فرضیه جهت دار فرض شده آن نوع فرضیه ای است که یک ارتباط مثبت یا یک ارتباط منفی را پیش بینی می کند، اما نه هر دو را.

فرض بر این است که ارزش نفر اول یا واحد اقلامی که نمونه برداری می شود تحت تأثیر ارزش نفر دوم یا واحد دیگر مورد نمونه قرار نمی گیرد. اگر داده ها ادغام یا متحد شوند، این فرض آزمون دقیق فیشر نقض می شود. در آزمون دقیق فیشر، انحصار متقابل در مشاهدات فرض شده است. به عبارت دیگر، مورد داده شده باید فقط در یک خانه در جدول قرار گیرد.

| fisher.test(table(race, schtyp)) |

| ## ## Fisher’s Exact Test for Count Data ## ## data: table(race, schtyp) ## p-value = 0.5975 ## alternative hypothesis: two.sided |

اجرای آزمون One-way ANOVA در R

تحلیل واریانس یک طرفه: هنگام مقایسه میانگین نمرات بیش از دو گروه از آنالیز واریانس (ANOVA) استفاده می شود. تحلیل واریانس یک طرفه شامل یک متغیر مستقل (به عنوان عامل) است که دارای تعدادی سطوح مختلف (گروه ها یا شرایط) است. متغیر وابسته یک متغیر پیوسته است. تجزیه و تحلیل واریانس، تنوع در نمرات بین گروه های مختلف و تنوع در هر گروه را مقایسه می کند. یک نسبت F محاسبه می شود. یک نسبت F بزرگ نشان می دهد که تنوع بیشتری بین گروه ها (علت متغیر مستقل) نسبت به هر گروه (اصطلاح خطا) وجود دارد.

آزمون F معنی دار نشان می دهد که گروه ها متفاوت هستند. با این حال، این نشان نمی دهد که کدام یک از گروه ها متفاوت است. برای این کار، باید تست های پس از آن را انجام دهید.

| summary(aov(write ~ prog)) |

| ## Df Sum Sq Mean Sq F value Pr(>F) ## prog 2 3176 1588 21.3 4.3e-09 *** ## Residuals 197 14703 75 ## — ## Signif. codes: 0 ‘***’ 0.001 ‘**’ 0.01 ‘*’ 0.05 ‘.’ 0.1 ‘ ‘ 1 |

اجرای آزمون Kruskal Wallis test در R

آزمون Kruskal Wallis H نوعی آزمون ANOVA یک طرفه بر اساس رتبه بندی است که از روش های آماری برای مقایسه میانه های بیش از دو گروه استفاده می کند. بنابراین، می توان آن را برای تمام توزیع های حاوی متغیرهایی که سطوح پیوسته ترتیبی یا وابسته هستند، اعمال کرد. با این حال، اگر چه می تواند تعیین کند که کدام متغیرها در یک گروه غالب هستند، اما در پاسخ به دلیل تسلط ناکام است.

آزمون مورد نظر فقط زمانی قابل اجرا است که شرایط زیر وجود داشته باشد:

- یکی بیش از سه شرط برای مقایسه دارد.

- هر شرایطی توسط یک گروه شرکتکننده مشخص تنظیم میشود، به این معنی که اگر یک طرح معیارهای استقلال دارای بیش از سه شرط باشد.

- داده های اعمال آزمون به طور معمول توزیع نمی شود.

- داده های اندازه گیری شده دارای واریانس های متفاوتی هستند که مربوط به شرایط مختلف است.

پس از برآورده شدن شرایط فوق، آزمایش انجام می شود تا بررسی شود که آیا نتیجه یک گروه تحت آزمایش بر نتیجه نمونه مورد نظر دیگر تأثیر می گذارد یا خیر. این آزمون مجموعه های مختلف داده را برای درک مبادله نمونه های داده در میان مجموعه داده های متعدد ارزیابی می کند. سپس از فرضیه صفر برای دانستن اینکه آیا میانه ها بر خلاف فرضیه جایگزین برابر هستند استفاده می شود، که نشان می دهد حداقل در یکی از نمونه ها تفاوت وجود دارد. یادگیری ماشینی همچنین از آزمون کمک می گیرد تا تفاوت بین دو یا چند گروه را بدون بیان دلیل تفاوت موجود بین آن ها مشخص کند.

اجازه دهید با یادگیری اینکه چگونه اضطراب امتحان بر نتایج آزمون تأثیر می گذارد، مفهوم را درک کنیم. سه مقدار ممکن برای متغیر مستقل “اضطراب امتحان” وجود دارد :

- بدون اضطراب،

- اضطراب کم و متوسط و

- اضطراب بالا.

متغیر وابسته نمره امتحان است که از 0 تا 100 درصد مقیاس بندی شده است. مثال دیگر یادگیری این است که چگونه وضعیت اجتماعی-اقتصادی بر ادراک افزایش مالیات بر فروش تأثیر می گذارد. وضعیت اجتماعی و اقتصادی دارای سه سطح است:

- طبقه کارگر،

- طبقه متوسط و

- ثروتمند،

این ها متغیر مستقل هستند. متغیر وابسته در مقیاس لیکرت 5 درجه ای از کاملاً موافقم تا کاملاً مخالفم اندازه گیری می شود.

مفروضات: متغیرهای محقق باید شامل مفروضات آزمون کروسکال والیس زیر باشد:

- دو یا چند ردیف و یک متغیر مستقل (گروه های مستقل). این آزمون زمانی بیشتر انجام می شود که آماردانان دارای سه سطح یا بیشتر باشند. به جای آن از آزمون U Mann-Whitney برای دو سطح استفاده کنید.

- متغیرهای وابسته با فاصله، نسبت یا مقیاس ترتیبی.

- مشاهدات آماردانان باید بی طرفانه باشد. به عبارت دیگر، نباید هیچ ارتباطی بین افراد تشکیل دهنده هر گروه یا بین گروه ها داشته باشد.

- توزیع اشکال برای همه گروه ها باید یکنواخت باشد.

| kruskal.test(write, prog) |

| ## ## Kruskal-Wallis rank sum test ## ## data: write and prog ## Kruskal-Wallis chi-squared = 34, df = 2, p-value = 4.047e-08 |

اجرای آزمون Paired t-test در R

تست تی زوجی: آزمون t نمونه جفتی که گاهی به آن آزمون t نمونه وابسته نیز گفته می شود، یک روش آماری است که برای تعیین اینکه آیا میانگین تفاوت بین دو مجموعه مشاهدات صفر است یا خیر. در یک آزمون t نمونه زوجی، هر موضوع یا موجودیت دو بار اندازه گیری می شود که منجر به جفت مشاهدات می شود. کاربردهای رایج آزمون t نمونه زوجی شامل مطالعات مورد شاهدی یا طرحهای اندازه گیری مکرر است. فرض کنید شما علاقه مند به ارزیابی اثربخشی یک برنامه آموزشی شرکت هستید. یکی از رویکردهایی که ممکن است در نظر بگیرید این است که عملکرد نمونهای از کارمندان را قبل و بعد از تکمیل برنامه اندازهگیری کنید و تفاوتها را با استفاده از آزمون t نمونه جفتی تحلیل کنید.

فرضیه ها: مانند بسیاری از روش های آماری، آزمون t نمونه زوجی دارای دو فرضیه رقابتی است، فرضیه صفر و فرضیه جایگزین. فرضیه صفر فرض میکند که تفاوت میانگین واقعی بین نمونههای زوج صفر است. تحت این مدل، همه تفاوتهای قابل مشاهده با تغییرات تصادفی توضیح داده میشوند.

برعکس، فرضیه جایگزین فرض میکند که تفاوت میانگین واقعی بین نمونههای زوجی برابر با صفر نیست. فرضیه جایگزین بسته به نتیجه مورد انتظار می تواند یکی از چندین شکل را داشته باشد. اگر جهت تفاوت مهم نباشد، از فرضیه دو دنباله استفاده می شود. در غیر این صورت می توان از فرضیه دم بالا یا پایین برای افزایش قدرت آزمون استفاده کرد. فرضیه صفر برای هر نوع فرضیه جایگزین یکسان باقی می ماند.

| t.test(write, read, paired = TRUE) |

| ## ## Paired t-test ## ## data: write and read ## t = 0.867, df = 199, p-value = 0.3868 ## alternative hypothesis: true difference in means is not equal to 0 ## 95 percent confidence interval: ## -0.694 1.784 ## sample estimates: ## mean of the differences ## 0.545 |

اجرای آزمون Wilcoxon signed rank sum test در R

آزمون رتبهبندی علامتدار ویلکاکسون که بهعنوان آزمون مجموع رتبههای امضاشده ویلکاکسون و آزمون جفتهای همسان ویلکاکسون نیز شناخته میشود، یک آزمون آماری ناپارامتریک است که برای مقایسه دو نمونه وابسته (به عبارت دیگر، دو گروه متشکل از نقاط دادهای که عبارتند از: همسان یا جفت شده). مانند سایر آزمونهای ناپارامتریک، این آزمون هیچ توزیع خاصی از دادههای مورد تجزیه و تحلیل را فرض نمیکند (برای مثال، آیا توزیع نرمال را میگیرد یا خیر). معادل پارامتری آزمون رتبه علامت دار ویلکاکسون، آزمون t نمونه های وابسته (یا آزمون t زوجی) است.

آزمون رتبهبندی علامتدار Wilcoxon میتواند هنگام مقایسه یک نمونه با یک مقدار مشخص، به عنوان یک معادل ناپارامتریک با آزمون z یا آزمون t استفاده شود. با این حال، ما در اینجا بر استفاده از آزمون رتبه امضا شده Wilcoxon در تجزیه و تحلیل داده های زوجی تمرکز می کنیم. همانند آزمون U Mann-Whitney و آزمون Kruskal Wallis، آزمون رتبه امضا شده Wilcoxon بر اساس رتبه هایی است که به نقاط داده نسبت داده شده است تا داده های مشاهده شده واقعی.

فرضیههای آزمون رتبهبندی ویلکاکسون برای دادههای زوجی به شرح زیر است:

- فرضیه صفر (H0) این است که تفاوت بین مشاهدات زوجی در جامعه صفر است.

- فرضیه جایگزین (H1) این است که تفاوت بین مشاهدات زوجی برابر با صفر نیست.

همانند آزمون Mann-Whitney U، میتوانید این را به عنوان مقایسه میانههای تفاوت بین مشاهدات زوجی تفسیر کنید، اما توجه داشته باشید که میانهها در محاسبه آمار آزمون دخالتی ندارند. زمان استفاده از آزمون رتبه بندی علامت دار ویلکاکسون:

از آن جایی که این یک آزمون ناپارامتریک بزرگی تفاوت بین دادههای زوجی است، نتیجه میشود که متغیر مورد نظر باید پیوسته (قابلیت گرفتن عددی در یک محدوده) یا گسسته (دادههایی که فقط میتوانند مقادیر معینی بگیرند) باشد. همچنین مهم است که بفهمیم وقتی می گوییم داده ها جفت شده اند، منظورمان چیست.

دادههای جفتی زمانی به وجود میآیند که مشاهدات یک نمونه مستقل به طور منحصربهفردی با مشاهدات در نمونه مستقل دیگر مطابقت یابند. این ممکن است به این دلیل باشد که آنها از یک فرد (مانند اندازهگیریهای تکراری فشار خون قبل و بعد از درمان) یا از افراد مرتبط (مانند خواهر و برادر یا شرکتکنندگان همسان از یک درمان دارویی در مقابل بازوی کنترلی یک کارآزمایی بالینی هستند).

مهم است که داده های جفتی به این صورت تجزیه و تحلیل شوند و به عنوان نمونه های مستقل تلقی نشوند. تستهای ناپارامتریک، که به عنوان تستهای بدون توزیع نیز شناخته میشوند، هیچ فرضی در مورد شکل توزیع دادههای شما ندارند. هنگامی که مفروضات نرمال بودن داده ها برآورده نمی شوند، برای آزمایش فرضیه ها استفاده می شوند. معمولاً این در زمینه مجموعه داده های کوچکی است که به طور معمول توزیع نمی شوند.

| wilcox.test(write, read, paired = TRUE) |

| ## ## Wilcoxon signed rank test with continuity correction ## ## data: write and read ## V = 9261, p-value = 0.3666 ## alternative hypothesis: true location shift is not equal to 0 |

اجرای آزمون McNemar test در R

تست مک نمار: برای متغیرهای اسمی در قالب جدول 2×2 می توان از سه نوع آزمون آماری استفاده کرد. اولین مورد آزمایش دقیق فیشر است. پیش شرط استفاده از آن داده های باینری و نمونه های جفت نشده است. دومین مورد، آزمون مک نمار است که به داده های باینری مانند دقیق فیشر نیاز دارد، البته با نمونه های جفت شده. سومین آزمایش، آزمون مجذور کای است که به حجم نمونه بیش از 60 آزمودنی، با بیش از پنج شمارش در هر سلول نیاز دارد. آزمون مجذور کای همچنین می تواند برای جدول احتمالی بیش از 2×2، یعنی 3×3، 4×4 و غیره مفید باشد.

آزمون مک نمار یک آزمون ناپارامتریک است که برای تجزیه و تحلیل داده های اسمی زوج استفاده می شود. این یک آزمون روی یک جدول احتمالی 2×2 است و همگنی حاشیه ای دو متغیر دوگانه را بررسی می کند. آزمون به یک متغیر اسمی با دو دسته (دوگانه) و یک متغیر مستقل با دو گروه وابسته نیاز دارد. همچنین، دو گروه در متغیر وابسته باید متقابل باشند، یعنی نمی توانند در بیش از یک گروه باشند. اگر مقدار مجذور کای معنی دار باشد، فرضیه صفر رد می شود، به این معنی که تفاوت قابل توجهی در نسبت های حاشیه ای آزمون ها وجود دارد، به عنوان مثال، روش های درمانی/ تشخیصی جدیدتر/ نشانگر زیستی جایگزین بهتری برای عمل رایج است.

| X <- matrix(c(172, 7, 6, 15), 2, 2) mcnemar.test(X) |

| ## McNemar’s Chi-squared test with continuity correction ## data: X ## McNemar’s chi-squared = 0, df = 1, p-value = 1 |

اجرای آزمون One-way repeated measures ANOVA در R

ANOVA با اندازه گیریهای مکرر یکطرفه (همچنین به عنوان ANOVA درون آزمودنیها نیز شناخته میشود) برای تعیین این که آیا میانگینهای سه یا چند گروه متفاوت هستند در جایی که شرکتکنندگان در هر گروه یکسان هستند، استفاده میشود. به همین دلیل، گاهی اوقات گروه ها را گروه های «مرتبط» می نامند. شما اغلب به دو دلیل با این وضعیت روبرو می شوید:

- (الف) شرکت کنندگان در چند نقطه زمانی اندازه گیری شده اند تا ببینند آیا تغییراتی معمولاً در پاسخ به یک مداخله وجود داشته است یا خیر.

- (ب) شرکت کنندگان تحت بیش از یک شرط/آزمایش قرار گرفته اند و پاسخ به هر یک از این شرایط باید مقایسه شود.

برای مثال، میتوانید از ANOVA اندازهگیریهای مکرر یکطرفه استفاده کنید تا بفهمید که آیا تفاوتی در سطوح اضطراب در میان شرکتکنندگان با اضطراب متوسط پس از یک برنامه هیپنوتیزم درمانی با هدف کاهش اضطراب وجود دارد (مثلاً با سه نقطه زمانی:

- اضطراب بلافاصله قبل

- یک ماه پس از آن

- 6 ماه پس از برنامه هیپنوتیزم درمانی

در این مثال، “سطح اضطراب” متغیر وابسته شما است، در حالی که متغیر مستقل شما “زمان” است (یعنی با سه گروه مرتبط، که در آن هر یک از سه نقطه زمانی یک “گروه مرتبط” در نظر گرفته می شود). متناوباً، میتوانید از ANOVA اندازهگیریهای مکرر یک طرفه استفاده کنید تا بفهمید که آیا تفاوتی در عملکرد اسکی در سراشیبی بر اساس سه رنگ مختلف عینک اسکی وجود دارد (به عنوان مثال، عملکرد اسکی در سه شرایط: استفاده از عینکهای اسکی رنگی قهوهای، آبی و قرمز ). در این مثال، “عملکرد اسکی” متغیر وابسته شما است، در حالی که متغیر مستقل شما “شرط” است (به عنوان مثال، با سه گروه مرتبط، که در آن هر یک از سه شرط یک “گروه مرتبط” در نظر گرفته می شود).

| require(car) |

|

## Loading required package: car ## Loading required package: MASS ## Loading required package: nnet ## Loading required package: survival ## Loading required package: splines |

| require(foreign) |

| ## Loading required package: foreign |

| kirk <- within(read.dta(“آدرس دیتا شما”), { s <- as.factor(s) a <- as.factor(a) }) |

| model <- lm(y ~ a + s, data = kirk) analysis <- Anova(model, idata = kirk, idesign = ~s) print(analysis) ## Anova Table (Type II tests) ## ## Response: y ## Sum Sq Df F value Pr(>F) ## a 49.0 3 11.6 0.00011 *** ## s 31.5 7 3.2 0.01802 * ## Residuals 29.5 21 ## — ## Signif. codes: 0 ‘***’ 0.001 ‘**’ 0.01 ‘*’ 0.05 ‘.’ 0.1 ‘ ‘ 1 |

اجرای آزمون Repeated measures logistic regression در R

رگرسیون لجستیک تحلیل رگرسیونی مناسبی است که زمانی که متغیر وابسته دوگانه است (دودویی) انجام می شود. مانند تمام تحلیلهای رگرسیون، رگرسیون لجستیک یک تحلیل پیشبینیکننده است. رگرسیون لجستیک برای توصیف داده ها و توضیح رابطه بین یک متغیر باینری وابسته و یک یا چند متغیر مستقل اسمی، ترتیبی، بازه ای یا نسبتی استفاده می شود. رگرسیون لجستیک در اوایل قرن بیستم در علوم زیستی مورد استفاده قرار گرفت. سپس در بسیاری از کاربردهای علوم اجتماعی مورد استفاده قرار گرفت. رگرسیون لجستیک زمانی استفاده می شود که متغیر وابسته (هدف) مقوله ای باشد. مثلا:

- برای پیش بینی هرزنامه بودن ایمیل (1) یا (0)

- این که آیا تومور بدخیم است (1) یا نه (0)

سناریویی را در نظر بگیرید که در آن باید طبقه بندی کنیم که ایمیل اسپم است یا خیر. اگر برای این مسئله از رگرسیون خطی استفاده کنیم، نیاز به تعیین آستانه ای وجود دارد که بر اساس آن بتوان طبقه بندی را انجام داد. اگر کلاس واقعی بدخیم باشد، مقدار پیوسته پیش بینی شده 0.4 و مقدار آستانه 0.5 باشد، نقطه داده به عنوان غیر بدخیم طبقه بندی می شود که می تواند منجر به عواقب جدی در زمان واقعی شود. از این مثال می توان استنباط کرد که رگرسیون خطی برای مسئله طبقه بندی مناسب نیست. رگرسیون خطی نامحدود است و این رگرسیون لجستیک را به تصویر می کشد. مقدار آن ها به شدت از 0 تا 1 متغیر است.

| require(lme4) |

|

## Loading required package: lme4 ## Loading required package: Matrix ## Loading required package: lattice ## Attaching package: ‘lme4’ ## The following object(s) are masked from ‘package:stats’: |

| exercise <- within(read.dta(“https://stats.idre.ucla.edu/stat/stata/whatstat/exercise.dta”), { id <- as.factor(id) diet <- as.factor(diet) }) glmer(highpulse ~ diet + (1 | id), data = exercise, family = binomial) |

|

## Generalized linear mixed model fit by the Laplace approximation ## Formula: highpulse ~ diet + (1 | id) ## Data: exercise ## AIC BIC logLik deviance ## 105 113 -49.7 99.5 ## Random effects: ## Groups Name Variance Std.Dev. ## id (Intercept) 3.32 1.82 ## Number of obs: 90, groups: id, 30 ## ## Fixed effects: ## Estimate Std. Error z value Pr(>|z|) |

اجرای آزمون Factorial ANOVA در R

فاکتوریل چیست؟ فاکتوریل آزمون واریانس است که از بیش از یک متغیر مستقل طبقهبندی استفاده میکند. ANOVA دو طرفه نوعی ANOVA فاکتوریل است. برخی از نمونههای آزمون فاکتوریل عبارتند از:

- آزمایش اثرات ترکیبی واکسیناسیون (واکسینه شده یا واکسینه نشده) و وضعیت سلامت (شرایط سالم یا از قبل موجود) بر میزان عفونت آنفولانزا در یک جمعیت.

- بررسی تأثیر وضعیت تاهل (متاهل، مجرد، مطلقه، بیوه)، وضعیت شغلی (شاغل، خوداشتغال، بیکار، بازنشسته) و سابقه خانوادگی (بدون سابقه خانوادگی، برخی سابقه خانوادگی) بر بروز افسردگی در یک جمعیت .

- آزمایش تأثیر نوع خوراک (نوع A، B، یا C) و ازدحام انبار (غیر ازدحام، تا حدودی شلوغ، بسیار شلوغ) بر وزن نهایی جوجه ها در یک عملیات پرورش تجاری.

| anova(lm(write ~ female * ses, data = hsb2)) |

| ## Analysis of Variance Table ## ## Response: write ## Df Sum Sq Mean Sq F value Pr(>F) ## female 1 1176 1176 14.7 0.00017 *** ## ses 1 1042 1042 13.1 0.00039 *** ## female:ses 1 0 0 0.0 0.98276 ## Residuals 196 15660 80 ## — ## Signif. codes: 0 ‘***’ 0.001 ‘**’ 0.01 ‘*’ 0.05 ‘.’ 0.1 ‘ ‘ 1 |

اجرای آزمون Friedman test در R

آزمون فریدمن چیست؟ آزمون فریدمن آزمایش می کند که آیا تفاوت های آماری معنی داری بین سه یا چند نمونه وابسته وجود دارد یا خیر. نمونه وابسته چیست؟ در یک نمونه وابسته، مقادیر اندازه گیری شده به هم متصل می شوند. مثلاً اگر نمونه ای از افرادی که جراحی زانو انجام داده اند گرفته شود و این افراد هر کدام قبل از جراحی و یک و دو هفته بعد از جراحی مورد بررسی قرار گیرند، نمونه وابسته است. این به این دلیل است که با یک فرد در چند مقطع زمانی مصاحبه شده است.

ممکن است به درستی بگویید که آنالیز واریانس با اندازهگیریهای مکرر دقیقاً همان چیزی را آزمایش میکند، زیرا همچنین آزمایش میکند که آیا بین سه یا چند نمونه وابسته تفاوت وجود دارد یا خیر؟ درست است، آزمون فریدمن همتای ناپارامتریک تحلیل واریانس با اندازه گیری های مکرر است. اما تفاوت این دو آزمون چیست؟ تجزیه و تحلیل واریانس میزان تفاوت مقادیر اندازه گیری شده نمونه وابسته را آزمایش می کند. از سوی دیگر، آزمون فریدمن، به جای مقادیر واقعی اندازه گیری شده، از رتبه ها استفاده می کند.

فرضیه ها در آزمون فریدمن: این ما را به سوال تحقیق می رساند که می توانید با آزمون فریدمن به آن پاسخ دهید. سوال تحقیق این است که آیا بین بیش از دو گروه وابسته تفاوت معناداری وجود دارد؟ بنابراین فرضیه صفر و جایگزین این است:

- فرضیه صفر: بین گروه های وابسته تفاوت معناداری وجود ندارد.

- فرضیه جایگزین: بین گروه های وابسته تفاوت معناداری وجود دارد.

نمونه تست فریدمن: شاید برای شما جالب باشد که بدانید آیا درمان پس از فتق دیسک بر درک بیمار از درد تأثیر دارد یا خیر. برای این منظور، احساس درد را قبل از درمان، در اواسط درمان و در پایان درمان اندازه گیری می کنید. اکنون می خواهید بدانید که آیا تفاوتی بین نقاط زمانی مختلف وجود دارد یا خیر. بنابراین، متغیر مستقل شما زمان یا پیشرفت درمان در طول زمان است. متغیر وابسته شما درک درد است. اکنون شما یک پیشرفت درک درد از هر فرد در طول زمان دارید و اکنون می خواهید بدانید که آیا درمان بر درک درد تأثیر دارد یا خیر. به زبان ساده، در این مورد درمان تاثیر دارد و در این مورد درمان تاثیری بر درک درد ندارد. در طول زمان، درک درد در اینجا تغییر نمی کند، در این مورد تغییر می کند.

| friedman.test(cbind(read, write, math)) |

| ## ## Friedman rank sum test ## ## data: cbind(read, write, math) ## Friedman chi-squared = 0.645, df = 2, p-value = 0.7244 |

اجرای آزمون Factorial logistic regression در R

رگرسیون لجستیک تحلیل رگرسیونی است که زمانی انجام می شود که متغیر وابسته اسمی با بیش از دو سطح باشد. مشابه رگرسیون خطی چندگانه، رگرسیون لجستیک یک تحلیل پیش بینی است. رگرسیون چند جمله ای برای توضیح رابطه بین یک متغیر وابسته اسمی و یک یا چند متغیر مستقل استفاده می شود.

رگرسیون خطی استاندارد مستلزم آن است که متغیر وابسته در مقیاس پیوسته (فاصله یا نسبت) اندازه گیری شود. رگرسیون لجستیک باینری فرض می کند که متغیر وابسته یک رویداد تصادفی است. متغیر وابسته نتیجه این رویداد تصادفی را با یک تابع چگالی (یک تابع از احتمالات انباشته شده از 0 تا 1) توصیف می کند. یک نقطه برش (به عنوان مثال، 0.5) می تواند برای تعیین اینکه کدام نتیجه توسط مدل بر اساس مقادیر پیش بینی کننده ها پیش بینی می شود استفاده شود.

| summary(glm(female ~ prog * schtyp, data = hsb2, family = binomial)) |

| ## ## Call: ## glm(formula = female ~ prog * schtyp, family = binomial, data = hsb2) ## ## Deviance Residuals: ## Min 1Q Median 3Q Max ## -1.89 -1.25 1.06 1.11 1.20 ## ## Coefficients: ## Estimate Std. Error z value Pr(>|z|) ## (Intercept) -0.0513 0.3204 -0.16 0.87 ## prog2 0.3246 0.3911 0.83 0.41 ## prog3 0.2183 0.4319 0.51 0.61 ## schtyp2 1.6607 1.1413 1.46 0.15 ## prog2:schtyp2 -1.9340 1.2327 -1.57 0.12 ## prog3:schtyp2 -1.8278 1.8402 -0.99 0.32 ## ## (Dispersion parameter for binomial family taken to be 1) ## ## Null deviance: 275.64 on 199 degrees of freedom ## Residual deviance: 272.49 on 194 degrees of freedom ## AIC: 284.5 ## ## Number of Fisher Scoring iterations: 3 |

اجرای آزمون Correlation در R

همبستگی چیست؟ همبستگی یک معیار آماری است که میزان ارتباط خطی دو متغیر را بیان می کند (به این معنی که آنها با هم با یک نرخ ثابت تغییر می کنند). این یک ابزار رایج برای توصیف روابط ساده بدون اظهار نظر در مورد علت و معلول است. همبستگی چگونه اندازه گیری می شود؟ ضریب همبستگی نمونه، r، قدرت رابطه را کمی نشان می دهد. همبستگی ها برای معنی دار بودن آماری نیز آزمایش می شوند.

برخی از محدودیت های تحلیل همبستگی چیست؟ همبستگی نمی تواند حضور یا تأثیر سایر متغیرها را خارج از دو مورد بررسی قرار دهد. مهم این است که همبستگی در مورد علت و معلول به ما نمی گوید. همبستگی همچنین نمی تواند به طور دقیق روابط منحنی را توصیف کند.

همبستگی ها حرکت داده ها را با هم توصیف می کنند همبستگی ها برای توصیف روابط ساده بین داده ها مفید هستند. به عنوان مثال، تصور کنید که به مجموعه داده ای از کمپینگ ها در یک پارک کوهستانی نگاه می کنید. می خواهید بدانید که آیا رابطه ای بین ارتفاع کمپ (چقدر از کوه بلند است) و میانگین دمای بالا در تابستان وجود دارد یا خیر. برای هر اردوگاه جداگانه، دو معیار دارید: ارتفاع و دما. وقتی این دو متغیر را در نمونه خود با همبستگی مقایسه می کنید، می توانید یک رابطه خطی پیدا کنید: با افزایش ارتفاع، دما کاهش می یابد. همبستگی منفی دارند.

اعداد همبستگی به چه معناست؟ ما همبستگی ها را با یک اندازه گیری بدون واحد به نام ضریب همبستگی توصیف می کنیم که از 1- تا 1+ متغیر است و با r نشان داده می شود. اهمیت آماری با مقدار p نشان داده می شود. بنابراین، همبستگی ها معمولاً با دو عدد کلیدی نوشته می شوند: r = و p = .

- هر چه r به صفر نزدیکتر باشد، رابطه خطی ضعیف تر است.

- مقادیر r مثبت یک همبستگی مثبت را نشان می دهد، که در آن مقادیر هر دو متغیر تمایل به افزایش با هم دارند.

- مقادیر r منفی یک همبستگی منفی را نشان می دهد، که در آن مقادیر یک متغیر با کاهش مقادیر متغیر دیگر تمایل به افزایش دارند.

p-value شواهدی به ما می دهد که به طور معنی داری می توانیم نتیجه بگیریم که ضریب همبستگی جمعیت احتمالاً بر اساس آنچه از نمونه مشاهده می کنیم با صفر متفاوت است.

| cor(read, write) |

| ## [1] 0.597 |

| cor.test(read, write) |

| ## ## Pearson’s product-moment correlation ## ## data: read and write ## t = 10.5, df = 198, p-value < 2.2e-16 ## alternative hypothesis: true correlation is not equal to 0 ## 95 percent confidence interval: ## 0.499 0.679 ## sample estimates: ## cor ## 0.597 |

اجرای آزمون Simple linear regression در R

رگرسیون خطی ساده: برای تخمین رابطه بین دو متغیر کمی از رگرسیون خطی ساده استفاده می شود. هنگامی که می خواهید بدانید می توانید از رگرسیون خطی ساده استفاده کنید:

- چقدر رابطه بین دو متغیر قوی است (به عنوان مثال، رابطه بین بارندگی و فرسایش خاک).

- مقدار متغیر وابسته در مقدار معینی از متغیر مستقل (به عنوان مثال، میزان فرسایش خاک در سطح معینی از بارندگی).

مدل های رگرسیون رابطه بین متغیرها را با برازش یک خط به داده های مشاهده شده توصیف می کنند. مدل های رگرسیون خطی از خط مستقیم استفاده می کنند، در حالی که مدل های رگرسیون لجستیک و غیر خطی از خط منحنی استفاده می کنند. رگرسیون به شما امکان می دهد تا چگونگی تغییر یک متغیر وابسته را با تغییر متغیر(های) مستقل تخمین بزنید.

مثال رگرسیون خطی ساده: شما یک محقق اجتماعی هستید که به رابطه بین درآمد و شادی علاقه مند هستید. شما از 500 نفر که درآمدشان از 15 هزار تا 75 هزار است نظرسنجی می کنید و از آنها می خواهید که شادی خود را در مقیاس 1 تا 10 رتبه بندی کنند. متغیر مستقل (درآمد) و متغیر وابسته (شادی) هر دو کمی هستند، بنابراین می توانید تحلیل رگرسیون انجام دهید تا ببینید آیا رابطه خطی بین آن ها وجود دارد یا خیر. اگر بیش از یک متغیر مستقل دارید، به جای آن از رگرسیون خطی چندگانه استفاده کنید.

مفروضات رگرسیون خطی ساده: رگرسیون خطی ساده یک آزمون پارامتریک است، به این معنی که فرضیات خاصی را در مورد داده ها ایجاد می کند.

این مفروضات عبارتند از:

- همگنی واریانس (هماهنگی): اندازه خطا در پیشبینی ما در مقادیر متغیر مستقل تغییر قابل توجهی نمیکند.

- استقلال مشاهدات: مشاهدات موجود در مجموعه داده با استفاده از روشهای نمونهگیری معتبر آماری جمعآوری شدهاند و هیچ رابطه پنهانی بین مشاهدات وجود ندارد.

- نرمال بودن: داده ها از توزیع نرمال پیروی می کنند.

رگرسیون خطی یک فرض اضافی ایجاد می کند:

- رابطه بین متغیر مستقل و وابسته خطی است: خط بهترین تناسب از طریق نقاط داده یک خط مستقیم است (به جای یک منحنی یا نوعی عامل گروه بندی).

- اگر دادههای شما با مفروضات همسویی یا نرمال بودن مطابقت ندارند، ممکن است بتوانید به جای آن از یک آزمون ناپارامتریک مانند آزمون رتبه اسپیرمن استفاده کنید.

| lm(write ~ read) |

| ## ## Call: ## lm(formula = write ~ read) ## ## Coefficients: ## (Intercept) read ## 23.959 0.552 |

اجرای آزمون Non-parametric correlation در R

برخلاف ضریب همبستگی پیرسون، ضریب همبستگی اسپیرمن فقط مستلزم این است که هر متغیر حداقل در مقیاس ترتیبی اندازه گیری شود. همچنین هیچ فرض توزیعی ایجاد نمی کند، بنابراین می تواند برای متغیرهای اندازه گیری در جایی که فرض نرمال بودن دو متغیره برقرار نیست، استفاده شود. داده ها ممکن است شامل مشاهدات عددی باشد که برای آنها رتبه بندی اعمال می شود یا مشاهدات غیر عددی که فقط می توانند رتبه بندی شوند. در مورد تساوی در مقادیر X یا Y، یک رتبه متوسط اختصاص داده می شود.

از نظر محاسباتی ضریب همبستگی اسپیرمن به سادگی ضریب همبستگی پیرسون است که برای رتبهبندی مشاهدات اعمال میشود. مقدار ضریب می تواند از -1 (همبستگی منفی کامل) تا 0 (استقلال کامل بین رتبه بندی ها) تا +1 (همبستگی مثبت کامل) متغیر باشد. از آن جایی که معیاری برای خطی بودن مشاهدات رتبه بندی شده است، آزمایشی از روند یکنواخت داده های اصلی ارائه می دهد. البته توجه داشته باشید که نمی توان از آن برای تشخیص روند غیر یکنواخت استفاده کرد، به عنوان مثال در جایی که Y ابتدا با X افزایش می یابد، اما سپس در مقادیر بالاتر کاهش می یابد. از این رو روابط همیشه باید قبل از محاسبه ضریب ابتدا ترسیم شوند.

| cor.test(write, read, method = “spearman”) |

| ## Warning: Cannot compute exact p-values with ties |

| ## ## Spearman’s rank correlation rho ## ## data: write and read ## S = 510993, p-value < 2.2e-16 ## alternative hypothesis: true rho is not equal to 0 ## sample estimates: ## rho ## 0.617 |

اجرای آزمون Simple logistic regression در R

رگرسیون لجستیک ساده چیست؟ رگرسیون لجستیک ساده یک آزمون آماری است که برای پیشبینی یک متغیر باینری با استفاده از یک متغیر دیگر استفاده میشود. همچنین برای تعیین رابطه عددی بین دو متغیر استفاده می شود. متغیری که میخواهید پیشبینی کنید باید باینری باشد و دادههای شما باید سایر مفروضات ذکر شده در زیر را برآورده کند. رگرسیون لجستیک ساده یک روش آماری است که برای پیشبینی یک متغیر باینری با استفاده از یک متغیر پیوسته دیگر استفاده میشود. رگرسیون لجستیک ساده گاهی رگرسیون لاجیت یا رگرسیون لجستیک باینری نیز نامیده می شود.

مفروضات رگرسیون لجستیک ساده: هر روش آماری دارای مفروضاتی است. مفروضات به این معنی است که داده های شما باید ویژگی های خاصی را داشته باشند تا نتایج روش آماری دقیق باشد.

مفروضات رگرسیون لجستیک ساده عبارتند از:

- خطی بودن

- بدون موارد پرت

- استقلال

بیایید هر یک از اینها را جداگانه بررسی کنیم:

- خطی بودن: رگرسیون لجستیک یک منحنی لجستیک را با داده های باینری متناسب می کند. این منحنی لجستیک را می توان به عنوان احتمال مرتبط با هر نتیجه در بین مقادیر متغیر مستقل تفسیر کرد. رگرسیون لجستیک فرض می کند که رابطه بین لاگ طبیعی این احتمالات (هنگامی که به صورت شانس بیان می شود) و متغیر پیش بینی شما خطی است.

- بدون موارد پرت: متغیرهایی که به آنها اهمیت می دهید نباید دارای مقادیر پرت باشند. رگرسیون لجستیک به نقاط پرت یا داده هایی که مقادیر غیرمعمول بزرگ یا کوچک دارند حساس است. شما می توانید با ترسیم آن ها و مشاهده اینکه آیا هر نقطه ای از سایر نقاط دور است، متوجه شوید که آیا متغیرهای شما دارای نقاط پرت هستند یا خیر.

- استقلال: هر یک از مشاهدات شما (نقاط داده) باید مستقل باشد. این بدان معنی است که هر مقدار از متغیرهای شما به هیچ یک از متغیرهای دیگر “وابسته” ندارد. به عنوان مثال، این فرض معمولاً هنگامی نقض می شود که در طول زمان چندین نقطه داده از یک واحد مشاهده وجود داشته باشد (مثلاً موضوع/شرکت کننده/مشتری/فروشگاه)، زیرا نقاط داده از همان واحد مشاهده احتمالاً مرتبط هستند یا بر آن یکی دیگر تأثیر می گذارند.

چه زمانی از رگرسیون لجستیک ساده استفاده کنیم؟ شما باید از رگرسیون لجستیک ساده در سناریوی زیر استفاده کنید:

- شما می خواهید از یک متغیر در پیش بینی متغیر دیگر استفاده کنید، یا می خواهید رابطه عددی بین دو متغیر را کمی کنید.

- متغیری که می خواهید پیش بینی کنید (متغیر وابسته شما) باینری است

- شما یک متغیر مستقل یا یک متغیر دارید که به عنوان پیشبین از آن استفاده میکنید

بیایید این ها را روشن کنیم تا به شما کمک کنیم بدانید چه زمانی از رگرسیون لجستیک ساده استفاده کنید:

- پیش بینی: شما به دنبال یک آزمون آماری برای پیش بینی یک متغیر با استفاده از متغیر دیگر هستید. این یک سوال پیش بینی است. انواع دیگر تحلیل ها شامل بررسی قدرت رابطه بین دو متغیر (همبستگی) یا بررسی تفاوت بین گروه ها (تفاوت) است.

- متغیر وابسته باینری: متغیری که می خواهید پیش بینی کنید باید باینری باشد. داده های باینری تنها دو مقدار ممکن دارند. برخی از نمونههای دادههای باینری عبارتند از: درست/نادرست، محصول خریداری شده یا خیر، بیماری یا نبودن و ……

- انواع داده هایی که باینری نیستند شامل داده های مرتب شده (مانند مکان پایان مسابقه، بهترین رتبه بندی کسب و کار و …..)، داده های طبقه بندی شده (جنسیت، رنگ چشم، نژاد، و ……) یا داده های پیوسته (قد، درآمد و …… است).

| glm(female ~ read, family = binomial) |

| ## ## Call: glm(formula = female ~ read, family = binomial) ## ## Coefficients: ## (Intercept) read ## 0.7261 -0.0104 ## ## Degrees of Freedom: 199 Total (i.e. Null); 198 Residual ## Null Deviance: 276 ## Residual Deviance: 275 AIC: 279 |

اجرای آزمون Multiple logistic regression در R

زمانی که یک متغیر اسمی و دو یا چند متغیر اندازه گیری دارید، از رگرسیون لجستیک چندگانه استفاده کنید و می خواهید بدانید که متغیرهای اندازه گیری چگونه بر متغیر اسمی تأثیر می گذارند. میتوانید از آن برای پیشبینی احتمالات متغیر اسمی وابسته استفاده کنید، یا اگر دقت کردهاید، میتوانید از آن برای پیشنهادهایی درباره اینکه کدام متغیرهای مستقل تأثیر عمدهای بر متغیر وابسته دارند، استفاده کنید. چه زمانی از آن استفاده کنید؟

- زمانی که یک متغیر اسمی و دو یا چند متغیر اندازه گیری دارید از رگرسیون لجستیک چندگانه استفاده کنید. متغیر اسمی متغیر وابسته (Y) است. شما در حال مطالعه اثری هستید که متغیرهای مستقل (X) بر احتمال به دست آوردن مقدار خاصی از متغیر وابسته دارند. به عنوان مثال، ممکن است بخواهید بدانید که فشار خون، سن و وزن چه تاثیری بر احتمال حمله قلبی در سال آینده دارد.

- حمله قلبی در مقابل عدم حمله قلبی یک متغیر اسمی دو جمله ای است. فقط دو مقدار دارد شما می توانید رگرسیون لجستیک چند جمله ای را انجام دهید، که در آن متغیر اسمی بیش از دو مقدار دارد، اما من قصد دارم خودم را به رگرسیون لجستیک چندگانه باینری محدود کنم، که بسیار رایج تر است.

متغیرهای اندازه گیری متغیرهای مستقل (X) هستند. فکر می کنید ممکن است روی متغیر وابسته تأثیر بگذارند. در حالی که مثالهایی که در اینجا استفاده میکنم فقط دارای متغیرهای اندازهگیری به عنوان متغیرهای مستقل هستند، میتوان از متغیرهای اسمی به عنوان متغیرهای مستقل در یک رگرسیون لجستیک چندگانه استفاده کرد. اپیدمیولوژیست ها زیاد از رگرسیون لجستیک چندگانه استفاده می کنند، زیرا آنها به متغیرهای وابسته مانند زنده در مقابل مرده یا بیمار در مقابل سالم توجه دارند و در حال مطالعه افراد هستند و نمی توانند آزمایش های کنترل شده ای انجام دهند، بنابراین متغیرهای مستقل زیادی دارند.

| glm(female ~ read + write, family = binomial) |

| ## ## Call: glm(formula = female ~ read + write, family = binomial) ## ## Coefficients: ## (Intercept) read write ## -1.706 -0.071 0.106 ## ## Degrees of Freedom: 199 Total (i.e. Null); 197 Residual ## Null Deviance: 276 ## Residual Deviance: 248 AIC: 254 |

اجرای آزمون Ordered logistic regression در R

| require(MASS) |

| ## Creat order variable write3 as a factor with levels 1, 2, and 3 hsb2$write3 <- cut(hsb2$write, c(0, 48, 57, 70), right = TRUE, labels = c(1,2,3)) table(hsb2$write3) |

| ## ## 1 2 3 ## 61 61 78 |

| ## fit ordered logit model and store results ‘m’ m <- polr(write3 ~ female + read + socst, data = hsb2, Hess=TRUE) ## view a summary of the model summary(m) |

| ## Call: ## polr(formula = write3 ~ female + read + socst, data = hsb2, Hess = TRUE) ## ## Coefficients: ## Value Std. Error t value ## female 1.2854 0.3244 3.96 ## read 0.1177 0.0214 5.51 ## socst 0.0802 0.0194 4.12 ## ## Intercepts: ## Value Std. Error t value ## 1|2 9.704 1.197 8.108 ## 2|3 11.800 1.304 9.049 ## ## Residual Deviance: 312.55 ## AIC: 322.55 |

اجرای آزمون تحلیل تشخیصی در R

تجزیه و تحلیل تفکیکی یا تمیزی یت تشخیصی زمانی استفاده می شود که شما یک یا چند متغیر مستقل با فاصله معمولی توزیع شده و یک متغیر وابسته طبقه بندی داشته باشید. این یک تکنیک چند متغیره است که ابعاد پنهان در متغیرهای مستقل را برای پیش بینی عضویت گروه در متغیر وابسته طبقهای در نظر میگیرد. به عنوان مثال، با استفاده از دادههای hsb2 میگوییم که میخواهیم از نمرات خواندن، نوشتن و ریاضی برای پیش بینی نوع برنامهای که دانش آموز به آن تعلق دارد (prog) استفاده کنیم.

| require(MASS) |

| fit <- lda(factor(prog) ~ read + write + math, data = hsb2) fit # show results |

| ## Call: ## lda(factor(prog) ~ read + write + math, data = hsb2) ## ## Prior probabilities of groups: ## 1 2 3 ## 0.225 0.525 0.250 ## ## Group means: ## read write math ## 1 49.8 51.3 50.0 ## 2 56.2 56.3 56.7 ## 3 46.2 46.8 46.4 ## ## Coefficients of linear discriminants: ## LD1 LD2 ## read 0.0292 0.0439 ## write 0.0383 -0.1370 ## math 0.0703 0.0793 ## ## Proportion of trace: ## LD1 LD2 ## 0.9874 0.0126 |

اجرای آزمون One-way MANOVA در R

MANOVA یک طرفه چیست؟ در اصل MANOVA مخفف عبارت Multivariate Analysis Of Variance است. هدف اصلی از آنالیز واریانس یک طرفه آزمایش این است که آیا دو یا چند گروه در یک یا چند ویژگی به طور قابل توجهی با یکدیگر تفاوت دارند یا خیر. ANOVA فاکتوریل میانگین ها را در دو یا چند متغیر مقایسه می کند. مجدداً، یک ANOVA یک طرفه دارای یک متغیر مستقل است که نمونه را به دو یا چند گروه تقسیم می کند در حالی که ANOVA فاکتوریل دارای دو یا چند متغیر مستقل است که نمونه را به چهار یا چند گروه تقسیم می کند.

یک MANOVA اکنون دو یا چند متغیر مستقل و دو یا چند متغیر وابسته دارد. برای برخی از آماردانان، MANOVA نه تنها تفاوتهای میانگین نمرات را بین چند گروه مقایسه میکند، بلکه یک رابطه علت اثر را نیز فرض میکند که به موجب آن یک یا چند متغیر مستقل و کنترلشده (عوامل) باعث تفاوت معنیدار یک یا چند ویژگی میشوند. فاکتورها نقاط داده را در یکی از گروه ها مرتب می کنند که باعث تفاوت در مقدار میانگین گروه ها می شود.

نمونه هایی از سوالات معمولی که توسط MANOVA پاسخ داده می شوند به شرح زیر است:

- پزشکی – آیا دارو اثر دارد؟ آیا میانگین امید به زندگی، درد درک شده و سطح عوارض جانبی بین سه گروه آزمایشی که دارو را در مقابل محصول ثابت شده دریافت کردند، در مقایسه با گروه کنترل تفاوت معنیداری دارد – و در هر یک از گروهها دو زیر گروه برای دوز بالا در مقابل دوز پایین دوز؟

- جامعه شناسی – آیا افراد ثروتمندی که در روستا زندگی می کنند شادتر هستند؟ آیا آن ها بیشتر از زندگی خود لذت می برند و نگاه مثبت تری به آینده خود دارند؟ آیا طبقات مختلف درآمدی رضایت، لذت و دیدگاه متفاوتی نسبت به زندگی خود گزارش می کنند؟ آیا منطقه ای که در آن زندگی می کنند (حومه / شهر / روستا) بر شادی و دیدگاه مثبت آن ها تأثیر می گذارد؟

- مطالعات مدیریت – کدام برندها از ماتریس BCG وفاداری مشتری، جذابیت برند و رضایت مشتری بالاتری دارند؟ ماتریس BCG برندهای موجود در سبد برند را با نرخ رشد کسب و کار (بالا/کم) و سهم بازار (بالا/کم) اندازهگیری میکند. مشتریان نسبت به کدام برند وفادارتر، جذب و رضایت بیشتری دارند؟ ستاره ها، گاوهای نقدی، سگ ها یا علامت سوال؟

| summary(manova(cbind(read, write, math) ~ prog)) |

| ## Df Pillai approx F num Df den Df Pr(>F) ## prog 2 0.267 10.1 6 392 2.3e-10 *** ## Residuals 197 ## — ## Signif. codes: 0 ‘***’ 0.001 ‘**’ 0.01 ‘*’ 0.05 ‘.’ 0.1 ‘ ‘ 1 |

اجرای آزمون Multivariate multiple regression در R

رگرسیون خطی چند متغیره چیست؟ رگرسیون خطی چند متغیره یک آزمون آماری است که برای پیشبینی متغیرهای چندگانه با استفاده از یک یا چند متغیر دیگر استفاده میشود. همچنین برای تعیین رابطه عددی بین این مجموعه از متغیرها و سایر متغیرها استفاده می شود. متغیری که میخواهید پیشبینی کنید باید پیوسته باشد و دادههای شما باید با سایر مفروضات فهرستشده در زیر مطابقت داشته باشد. رگرسیون خطی چند متغیره یک روش آماری است که برای پیشبینی یک یا چند متغیر وابسته با استفاده از یک یا چند متغیر مستقل استفاده میشود.

مفروضات رگرسیون خطی چند متغیره: هر روش آماری دارای مفروضاتی است. مفروضات به این معنی است که داده های شما باید ویژگی های خاصی را داشته باشند تا نتایج روش آماری دقیق باشد. مفروضات رگرسیون خطی چند متغیره عبارتند از:

- خطی بودن

- بدون موارد پرت

- همگنی واریانس ها

- نرمال بودن باقیمانده ها

- بدون چند خطی

بیایید هر یک از این ها را جداگانه بررسی کنیم:

- خطی بودن : متغیرهایی که به آن ها اهمیت می دهید باید به صورت خطی مرتبط باشند. این بدان معنی است که اگر متغیرها را رسم کنید، می توانید یک خط مستقیم متناسب با شکل داده ها ترسیم کنید.

- بدون موارد پرت: متغیرهایی که به آنها اهمیت می دهید نباید دارای مقادیر پرت باشند. رگرسیون خطی به نقاط پرت یا داده هایی که مقادیر غیرمعمول بزرگ یا کوچک دارند حساس است. شما می توانید با ترسیم آنها و مشاهده اینکه آیا هر نقطه ای از سایر نقاط دور است، متوجه شوید که آیا متغیرهای شما دارای نقاط پرت هستند یا خیر.

- همگنی واریانس ها: در آمار به این حالت homoscedasticity می گویند، که توصیف می کند زمانی که متغیرها در محدوده خود دارای یک پراکندگی مشابه هستند.Homoscedasticity متغیری را توصیف می کند که در محدوده آن به یک اندازه گسترش دارد. در این شکل، دو متغیر در نمودار بالا این فرض را برآورده می کنند، در حالی که دو متغیر در نمودار پایین این فرض را برآورده نمی کنند.

- نرمال بودن باقیمانده ها: کلمه “باقیمانده” به مقادیر حاصل از کم کردن متغیرهای وابسته مورد انتظار (یا پیش بینی شده) از مقادیر واقعی اشاره دارد. توزیع این مقادیر باید با شکل توزیع نرمال (یا منحنی زنگی) مطابقت داشته باشد. برآورده کردن این فرض اطمینان می دهد که نتایج رگرسیون به طور یکسان در سراسر گسترش کامل داده ها قابل استفاده است و هیچ سوگیری سیستماتیک در پیش بینی وجود ندارد.

- چند خطی: همخطی چندگانه به سناریویی اطلاق می شود که دو یا چند متغیر مستقل به طور اساسی با یکدیگر همبستگی داشته باشند. وقتی چند خطی وجود دارد، ضرایب رگرسیون و اهمیت آماری ناپایدار و کمتر قابل اعتماد میشوند، اگرچه تأثیری بر تناسب مدل با دادهها ندارد.

چه زمانی از رگرسیون خطی چند متغیره استفاده کنیم؟ شما باید از رگرسیون خطی چند متغیره در سناریوی زیر استفاده کنید:

- شما می خواهید از یک متغیر در پیش بینی چندین متغیر دیگر استفاده کنید یا می خواهید رابطه عددی بین آنها را کمی کنید.

- متغیرهایی که می خواهید پیش بینی کنید (متغیر وابسته شما) پیوسته هستند

- شما بیش از یک متغیر مستقل یا یک متغیر دارید که از آن به عنوان پیش بینی کننده استفاده می کنید

- شما هیچ اندازه گیری مکرری از یک واحد مشاهده ندارید

- شما بیش از یک متغیر وابسته دارید

|

M1 <- lm(cbind(write, read) ~ female + math + science + socst, data = hsb2) require(car) |

| ## Multivariate Tests: socst ## Df test stat approx F num Df den Df Pr(>F) ## Pillai 1 0.221 27.5 2 194 3.1e-11 *** ## Wilks 1 0.779 27.5 2 194 3.1e-11 *** ## Hotelling-Lawley 1 0.283 27.5 2 194 3.1e-11 *** ## Roy 1 0.283 27.5 2 194 3.1e-11 *** ## — ## Signif. codes: 0 ‘***’ 0.001 ‘**’ 0.01 ‘*’ 0.05 ‘.’ 0.1 ‘ ‘ 1 |

اجرای آزمون Canonical correlation در R

همبستگی کانونی همبستگی بین دو نوع متعارف یا نهفته متغیر است. در همبستگی کانونی ، یک متغیر یک متغیر مستقل و متغیر دیگر یک متغیر وابسته است. برای محقق مهم است که بداند برخلاف تحلیل رگرسیون، محقق می تواند بین بسیاری از متغیرهای وابسته و مستقل رابطه پیدا کند. برای آزمایش اهمیت این همبستگی از آماری به نام Wilk’s Lamda استفاده شده است. کار همبستگی متعارف مانند همبستگی ساده است. در هر دوی این موارد، نکته ارائه درصدی از واریانسهای متغیر وابسته است که توسط متغیر مستقل توضیح داده میشود. بنابراین، همبستگی کانونی به عنوان ابزاری تعریف میشود که میزان رابطه بین این دو متغیر را اندازهگیری میکند.

مفروضات رگرسیون چندگانه نیز در این همبستگی فرض می شود. مفاهیم و اصطلاحات مرتبط با همبستگی کانونی وجود دارد. این مفاهیم و اصطلاحات به درک بهتر محقق کمک می کند. آن ها به شرح زیر است:

- 1. متغیر یا متغیر متعارف: در همبستگی کانونی به عنوان ترکیب خطی مجموعه ای از متغیرهای اصلی تعریف می شود. این متغیرها شکلی از متغیرهای پنهان هستند.

- 2. مقادیر ویژه: مقدار مقادیر ویژه در همبستگی متعارف تقریباً برابر با مجذور مقدار در نظر گرفته می شود. مقادیر ویژه اساساً نسبت واریانس در متغیر متعارف را منعکس میکنند، که با همبستگی کانونی که به دو مجموعه از متغیرها مربوط میشود توضیح داده میشود.

- 3. وزن کانونی : نام دیگر وزن متعارف ضریب کانونی است. وزن متعارف در همبستگی متعارف باید ابتدا استاندارد شود. سپس برای ارزیابی اهمیت نسبی سهم متغیر فرد استفاده می شود.

- 4. ضریب اشتراک متعارف: این ضریب در همبستگی کانونی به عنوان مجموع ضرایب ساختار مجذور برای نوع داده شده از متغیر تعریف می شود.

- 5. ضریب افزونگی، d: این ضریب در همبستگی کانونی اساساً درصد واریانس متغیرهای اصلی یک مجموعه را که از مجموعه های دیگر پیش بینی می شود، اندازه گیری می کند.

- 6. آزمون نسبت درستنمایی: این آزمون معناداری در همبستگی کانونی برای انجام آزمون معناداری تمامی منابع رابطه خطی بین دو متغیر کانونی استفاده می شود.

مفروضات خاصی برای انجام همبستگی متعارف توسط محقق مطرح می شود. آن ها به شرح زیر است:

- 1. فرض بر این است که از نوع بازه ای داده ها برای انجام همبستگی کانونی استفاده می شود.

- 2. در همبستگی کانونی فرض می شود که ماهیت روابط باید خطی باشد.

- 3. فرض بر این است که در حین انجام همبستگی کانونی باید چند خطی کمی در داده ها وجود داشته باشد. اگر دو مجموعه داده به شدت همبسته باشند، ضریب همبستگی کانونی ناپایدار است.

- 4. باید واریانس نامحدود در همبستگی متعارف وجود داشته باشد. اگر واریانس نامحدود نباشد، ممکن است همبستگی کانونی ناپایدار به نظر برسد.

| require(CCA) |

| cc(cbind(read, write), cbind(math, science)) |

اجرای آزمون Factor analysis در R